ADA BANASZAK: Podczas zbliżającej się konferencji Digital Cultures będzie można oglądać twoją instalację „The Future of Secrets”. Na czym polega jej działanie?

SARAH W. NEWMAN: U podstaw tej pracy leży bardzo prosta – przynajmniej z technicznego punktu widzenia – wymiana pomiędzy człowiekiem i maszyną. W centrum instalacji stoi komputer, na ekranie widnieje tekst: „Czy masz jakiś sekret? Wpisz go tutaj”. Możesz napisać, cokolwiek przychodzi ci do głowy. Aktywne uczestnictwo nie jest obowiązkowe, ale okazuje się, że większość osób w takiej sytuacji chętnie dzieli się swoimi tajemnicami. Kiedy maszyna odbierze twoją wiadomość, mała drukareczka, która stoi obok, wydrukuje dla ciebie sekret innej osoby. W Warszawie część instalacji będzie stanowić stacja dźwiękowa, gdzie uczestnicy usłyszą sekrety czytane przez maszynę.

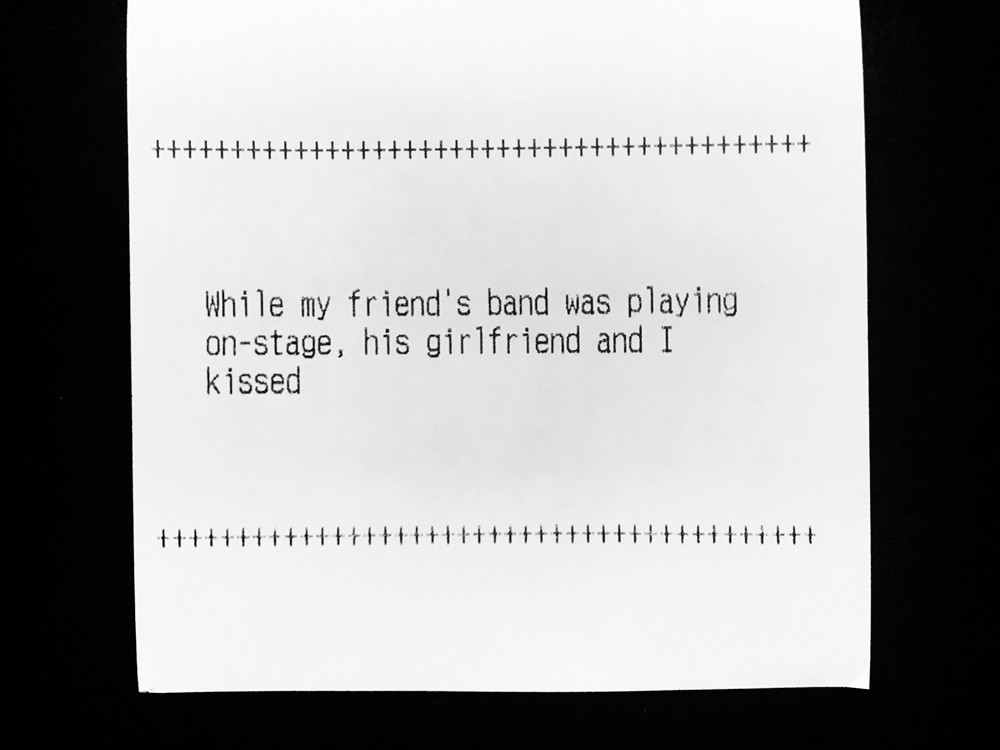

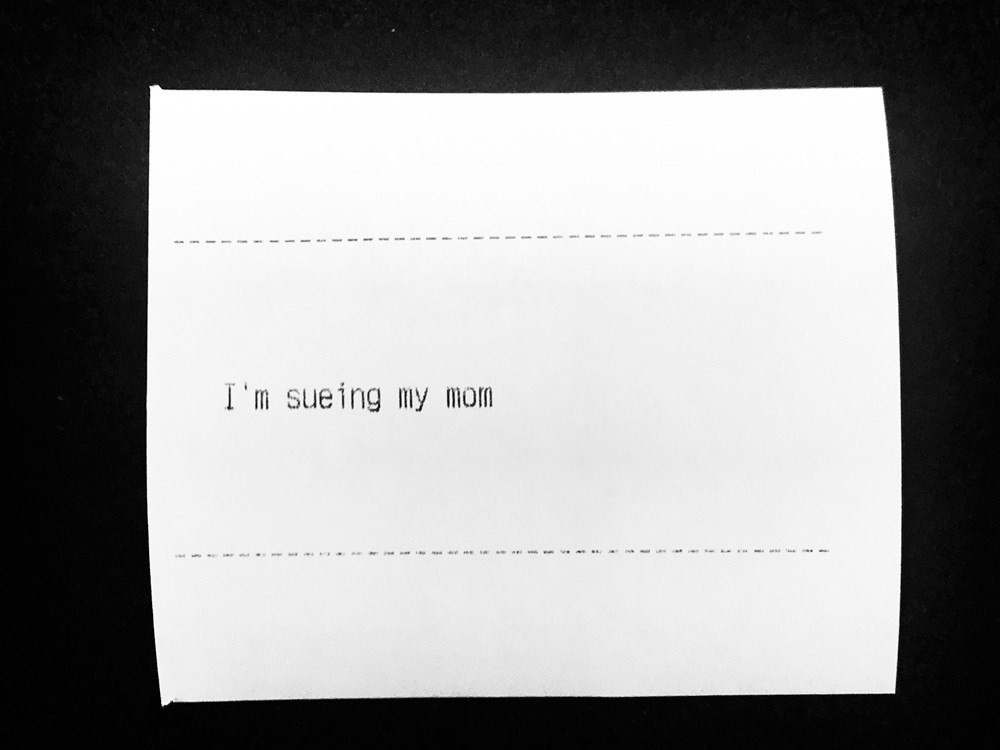

Jakimi tajemnicami ludzie najczęściej dzielą się z twoją maszyną?

Sekrety są bardzo różne – niektóre zabawne, inne poważne, czasem wręcz ponure. Wiele z nich dotyczy miłości, seksu i zdrad, zdarzały się wyznania typu „Mamy romans i w sobotę uciekamy razem z kraju”. Często powtarzającym się motywem są niespełnione marzenia czy różnego rodzaju wątpliwości lub fobie. Jedna z osób napisała, że wydaje jej się, że wszyscy oprócz niej są robotami, inna, że trzyma LSD w książkach filozoficznych. Niektórzy zwierzają się maszynie ze swoich występków z lat dziecięcych („Nakarmiłem kota złotą rybką mojego taty”, „W gimnazjum znęcałem się nad kolegami z klasy”), tak jakby związane z nimi poczucie winy wciąż ich prześladowało. To chyba najbardziej zaskakujący rodzaj wyznań – opowiadanie maszynie o czymś, co zrobiło się w wieku kilku lub kilkunastu lat i o czym nie mamy odwagi powiedzieć nikomu innemu.

Sarah W. Newman

Badaczka kreatywna w metaLAB na Uniwersytecie Harvarda, pracuje także w Ośrodku Berkman-Klein do Badań nad Internetem i Społeczeństwem. Tworzy instalacje artystyczne i rozwija projekty dotyczące roli technologii w kulturze, kreatywnie i krytycznie eksplorując znaczenie postnowoczesności. Prezentowała swoje prace w Nowym Jorku, San Francisco, Miami, Chicago, Berlinie i Rzymie, brała także udział w pobytach rezydencyjnych w Niemczech i Szwecji. Jej obecne prace badają społeczne oraz filozoficzne wymiary sztucznej inteligencji, osobliwe punkty styczne między „ludzkim” a „nieludzkim” oraz rolę sztuki jako środka wywołującego dialog i zaangażowanie odbiorców.

Dlaczego ludzie z taką łatwością dzielą się nawet intymnymi informacjami z komputerami czy smartfonami, skoro większość z nas ma świadomość, że za niemal każdym programem kryją się spece od marketingu i korporacje zbierające wszelkie możliwe dane?

„The Future of Secrets” umożliwia prawdziwie anonimową komunikację, natomiast gotowość, o której mówisz, do dzielenia się danymi o sobie nawet ze świadomością bycia nadzorowanym i monitorowanym, wynika ze specyfiki medium. Różne środki wyrazu pozwalają zaistnieć różnym stronom naszej osobowości – jeżeli jako narzędzie swojej pracy wybiorę aparat fotograficzny, to osiągnę inny efekt, niż gdybym to samo próbowała przedstawić za pomocą pędzla i płótna; podobnie sprawa ma się z komunikacją między ludźmi, wystarczy spojrzeć na różnice między mówieniem i pisaniem. Bycie online daje tak wiele zupełnie nowych i odmiennych możliwości, że decydujemy się z nich korzystać, idąc jednocześnie na kompromis dotyczący naszej prywatności. Pomyśl, jaką stratą byłaby niemożność wyrażania siebie w internecie! W obu przypadkach – zarówno dzieląc się informacjami online, jak i zachowując pełną prywatność, pozostając offline – coś tracimy.

Czy w związku z tą stałą inwigilacją algorytmy deep learning odpowiedzialne za wyświetlanie reklam lub podpowiadanie nam pytań w internetowej wyszukiwarce mogą wiedzieć o nas więcej, niż my sami wiemy o sobie?

Prawdopodobnie wiedzą o nas wiele rzeczy, z których nie zdajemy sobie sprawy, ponieważ śledzą i analizują nasze codzienne zachowania o wiele dokładniej, niż robimy to my sami. Nie zapominajmy jednak, że przypisujemy różnym systemom technologicznym sprawstwo i intencjonalność, którego one zwykle nie mają. Kiedy coś zupełnie losowego wydarza się na świecie, ludzie przypisują to przypadkowi. Ale kiedy maszyna produkuje jakąś informację, niezależnie od tego, czy dzieje się to losowo czy nie, większość z nas jest przekonana, że stoi za tym jakiś powód czy myśl. Badam to zjawisko w swoich pracach, tworząc dwuznaczne sytuacje, w których trudno jest ocenić, ile tak naprawdę maszyna czy system wie. Projektujemy na świat własne znaczenia. Myślę, że zauważenie tego mechanizmu może nas sporo nauczyć na temat naszych uprzedzeń, oczekiwań, nadziei, lęków i założeń. Takie łączenie kropek za pomocą oswojonych scenariuszy jest bardzo ludzką tendencją, w którą algorytmy oraz inne nieprzejrzyste procesy świetnie się wpisują. Przypisujemy intencjonalność systemom, których nie rozumiemy.

To, o czym mówisz, przypomina mi o zeszłorocznej, podsycanej przez media panice dotyczącej rozwijanych przez Facebooka algorytmów sztucznej inteligencji, które wynalazły swój własny, sekretny język i z tego powodu stały się tak niebezpieczne, że ich twórcy postanowili je zlikwidować. Oczywiście później okazało się, że był to po prostu błąd programu, który znalazł odzwierciedlenie w bełkocie produkowanym przez rzekomo konspirujące boty. Czy „The Future of Secrets” też wzbudza takie reakcje? Ludzie odczytują sekrety drukowane przez komputer jako świadome odpowiedzi na ich wiadomości?

Oczywiście. I, co więcej, czasem mają rację! Kiedy pierwszy raz pokazywałam tę instalację – w 2016 roku w Museum of Fine Arts w Bostonie – osoby w niej uczestniczące otrzymywały sekrety-odpowiedzi zupełnie losowo, ale wciąż słyszałam ludzi pytających: „Skąd ten komputer wiedział…?”. Skąd ten komputer wiedział, że to jest inny z moich sekretów? Skąd on wiedział, że właśnie o tym myślałem? Postanowiłam rozbudować nieco program i od tamtej pory niektóre odpowiedzi faktycznie nawiązują do pozostawionego przez kogoś sekretu. Ale ponieważ algorytm nie jest idealny – jedynie odrobinę bardziej skomplikowany niż był pierwotnie – czasem sekret wychodzący z maszyny nie jest doskonale dopasowany do sekretu do niej włożonego. To sprawia, że ludzie jeszcze częściej zastanawiają się, jak bardzo sprytna jest ta maszyna i ile tak naprawdę o nich wie.

Może chcą, żeby maszyna, której się zwierzają, była empatyczna, żeby okazała im zrozumienie?

Myślę, że nie w tym przypadku. Próbowałam skonstruować instalację jak najbardziej neutralnie, mój komputer nie jest zbyt ekspresyjny. Chciałam, żeby praca dotyczyła nie tyle empatii algorytmów, ile empatii ludzi. Czasami zamiast zatrzymać wydrukowany sekret dla siebie, ludzie kładą go w widocznym miejscu, tak by inni również mogli go przeczytać. Bywa, że pozostali uczestnicy idą w ich ślady, a instalacja powiększa się o tablicę zapisaną tajemnicami. W takiej sytuacji trudno się nie zastanawiać nad tym, czy któraś z nich nie należy na przykład do osoby, która siedzi obok ciebie. Ludzie odnajdują w sobie zapomniane pokłady empatii i zaczynają czuć się bardziej związani z innymi.

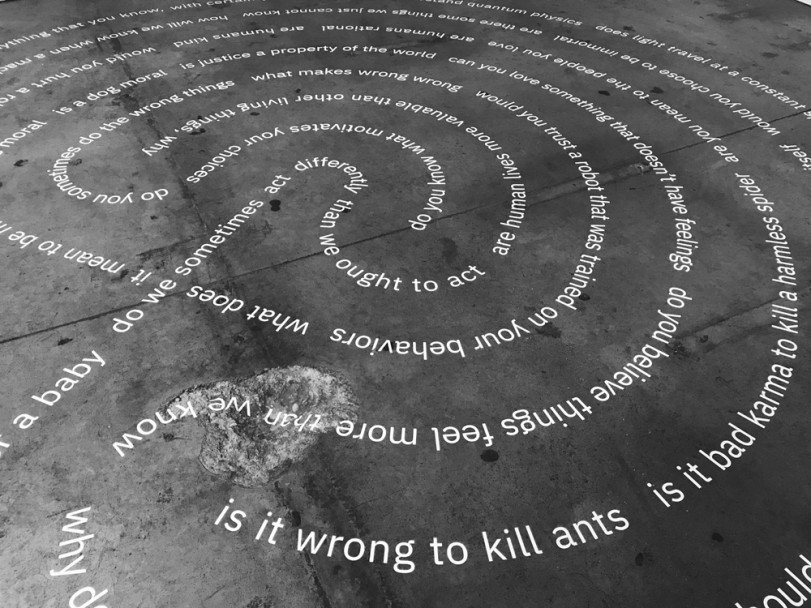

À propos empatii – przy okazji swojej pracy „Moral Labyrinth”, instalacji złożonej z filozoficznych pytań dotyczących ludzi i maszyn, pytasz, czy rozwój sztucznej inteligencji mógłby spowodować, że ludzie staną się bardziej szczerzy, skromni i współczujący.

Technologia sama w sobie nie sprawi, że zaczniemy postępować bardziej etycznie. Jeżeli tworzymy programy, które w przyszłości będą podejmować decyzje w imieniu ludzi, musimy osadzić je w pewnych systemach wartości, inaczej mogą dokonać wielkich szkód na drodze do wyznaczonego celu. Dla jasności: nie stanie się to dlatego, że będą złośliwe czy będą miały złą wolę, ponieważ algorytmy nie mogą być złe w sensie moralnym, ale dlatego, że programy są zoptymalizowane pod kątem celu i zawsze wybiorą najbardziej efektywny sposób jego osiągnięcia, jednak – co ważne – z uwzględnieniem parametrów i ograniczeń, które zostaną im podane na wejściu. Dlatego właśnie maszynom należy „mówić” wprost, jakie zachowania są nieakceptowalne, na przykład nie możesz robić testów na zwierzętach, nie możesz niszczyć środowiska naturalnego. I dlatego też tak ważne jest, byśmy jako ludzie określili swoje priorytety. Postęp umożliwią nam autorefleksja i międzykulturowy dialog, połączone ze zdobyczami technologicznymi.

Czy ten dialog doprowadziłby do stworzenia globalnego i opartego na konsensusie zestawu zasad, czy może przyszłość SI to wiele różnorodnych i lokalnych sztucznych inteligencji?

Kiedy myślę o tym, co mogłoby się wydarzyć, przychodzi mi do głowy dokument, który jest wynikiem międzynarodowego porozumienia, czyli Powszechna deklaracja praw człowieka – wiele z tych praw jest regularnie łamanych, ale to najbliższe temu, co moglibyśmy stworzyć jako ramy dla rozwoju SI. Potrzebujemy podstawowego spisu zasad, z którymi zgadza się jak największa liczba mieszkańców Ziemi, a pierwszym krokiem do stworzenia takiego dokumentu jest uświadomienie ludziom, z jakimi problemami wiąże się rozwój technologii sztucznej inteligencji, póki nie jest za późno.

Digital Cultures 2018

HYBRID MATTER

Międzynarodowa platforma spotkań polskich twórców z zagranicznymi twórcami i managerami kultury. Program interdyscyplinarnych debat i prezentacji ogniskuje się wokół czterech głównych obszarów: gier komputerowych, immersyjnego storytellingu, cyfrowych archiwów oraz nowoczesnego muzealnictwa. Organizowana przez Instytut Adama Mickiewicza konferencja ma na celu pozyskanie międzynarodowych partnerów dla polskich projektów, poszerzenie rynków dystrybucji polskich produkcji i zwiększenie rozpoznawalności polskich twórców cyfrowych zagranicą.

24–25 września 2018 roku, Warszawa

http://digitalcultures.pl

Wyobraź sobie, że naukowcy i inżynierowie pracują nad opartym na sztucznej inteligencji i podłączonym do sieci złożonym programem, którego celem ma być spowodowanie, że rak zniknie z Ziemi. Na początku swojego działania program przetwarza dane, uczy się, tworzy nawet parę skutecznych formuł leków – nie do końca wiemy jak, bo samouczące się algorytmy są „czarnymi pudełkami” – ale wszystko idzie gładko. Do momentu, w którym program zauważa, że jedynie żywi ludzie chorują na raka, więc aby usunąć raka decyduje się na zabicie wszystkich ludzi, wykorzystując swoje sieciowe połączenie ze wszystkimi reaktorami atomowymi na świecie. OK, ten przykład jest przesadą, bo nikt nie byłby na tyle mądry i głupi jednocześnie, żeby stworzyć tak mocną SI i dać jej tak sformułowany pojedynczy cel, ale myślę, że dobrze obrazuje, jak sztuczna inteligencja się uczy. Jeśli nie podamy jej odpowiednich wytycznych, może się stać coś naprawdę złego.

Wyobraź sobie, że naukowcy i inżynierowie pracują nad opartym na sztucznej inteligencji i podłączonym do sieci złożonym programem, którego celem ma być spowodowanie, że rak zniknie z Ziemi. Na początku swojego działania program przetwarza dane, uczy się, tworzy nawet parę skutecznych formuł leków – nie do końca wiemy jak, bo samouczące się algorytmy są „czarnymi pudełkami” – ale wszystko idzie gładko. Do momentu, w którym program zauważa, że jedynie żywi ludzie chorują na raka, więc aby usunąć raka decyduje się na zabicie wszystkich ludzi, wykorzystując swoje sieciowe połączenie ze wszystkimi reaktorami atomowymi na świecie. OK, ten przykład jest przesadą, bo nikt nie byłby na tyle mądry i głupi jednocześnie, żeby stworzyć tak mocną SI i dać jej tak sformułowany pojedynczy cel, ale myślę, że dobrze obrazuje, jak sztuczna inteligencja się uczy. Jeśli nie podamy jej odpowiednich wytycznych, może się stać coś naprawdę złego.

Grupa naukowców z Georgia Institute of Technology uczy sieci neuronowe społecznych konwencji za pomocą opowieści. Być może spojrzenie na sztuczną inteligencję w ten sam sposób, w jaki chcielibyśmy patrzeć na swoje dziecko, mogłoby pomóc w stworzeniu nieco bardziej przyjaznych ludziom i planecie programów?

Myślę, że ta analogia jest użyteczna i właściwie już traktujemy SI w ten sposób, chociażby ze względu na to, jak niektóre z tych systemów się uczą. Jednocześnie to porównanie nie jest wcale takie oczywiste. Rodzice zwykle chcą, żeby ich pociechy były lepsze niż oni sami, żeby ucząc się, naśladowały ich zalety, a nie wady. Gdy myślimy o sztucznej inteligencji w tym kontekście, musimy zadać sobie pytanie: czy chcemy, żeby te systemy były takie same jak człowiek, czy może o wiele lepsze? W tym pierwszym przypadku powinniśmy się zastanowić, po co w takim razie w ogóle rozwijać tę technologię, w drugim – gdzie jest nasze miejsce w tej relacji?

Jest jeszcze jeden niezwykle interesujący problem, dotyczący sztucznej inteligencji, która uczy się przez naśladowanie ludzkiego zachowania lub języka. Czasem zdarza się, że mówisz dziecku, że nie wolno kłamać, a za jakiś czas ono przyłapuje cię na kłamstwie. Czy w takiej sytuacji twoje dziecko – albo twój program – powinno przyjąć za wytyczne to, co mu powiedziałeś, czy to, co zrobiłeś? Problem sztucznej inteligencji, która ucząc się od ludzi, staje się nieszczera i zwodnicza, jest jak najbardziej realny. Został świetnie pokazany w science fiction, na przykład w filmie „Ex-Machina”.

„Moral Labyrinth” Sarah Newman, Ars Electronica Festival, Linz, Austra, 2018

„Moral Labyrinth” Sarah Newman, Ars Electronica Festival, Linz, Austra, 2018

Sporym wyzwaniem są również nasze – często głęboko ukryte – uprzedzenia, co pokazuje na przykład słynna historia programu Google Photos, który automatycznie podpisał zdjęcie czarnoskórej pary „Goryle”, ponieważ był uczony rozpoznawania ludzi jedynie na zdjęciach osób o jasnym kolorze skóry. Rasizm inżynierów jednej z największych firm technologicznych został ujawniony w spektakularny sposób. W jaki sposób twórcy programów opartych na SI, w większości biali mężczyźni z krajów zachodnich, powinni zmierzyć się z tym problemem?

Odpowiedzialność nie powinna spoczywać jedynie na twórcach. Powinna istnieć międzynarodowa instytucja, której zadaniem byłoby określanie standardów dotyczących zestawów danych, z których uczą się algorytmy, najlepiej na zasadzie konsultacji z różnymi grupami społecznymi, aby uniknąć tworzenia materiałów, w których znajdują odbicie czasem nawet nieuświadomione uprzedzenia. Obecnie pracuję z grupą, która właśnie zaczęła prototypować etykiety dla zestawów danych podobne do tych, które informują nas o wartości odżywczej jedzenia. To ciekawy eksperyment.

Gdyby tworzący technologie w oparciu o SI musieli przed rozpoczęciem pracy wejść do twojego moralnego labiryntu, jakie pytania byś im zadała?

Takie same, jak wszystkim. Celem tej pracy jest pokazanie, jak nasze automatyczne, szybkie odpowiedzi na pozornie oczywiste pytania rezonują w kontekście problemów technologicznych i jak w tym świetle przestają być oczywiste albo nawet takie same. Byłoby fantastycznie, gdyby osoby projektujące sztuczną inteligencję wzięły udział w tej instalacji – mogłyby stać się nieco bardziej świadome swoich decyzji i może trochę zwolniłyby, żeby poprosić o opinię lub podyskutować z kimś spoza swojego pola. „Moral Labyrinth” ma nam uświadomić, że nie jesteśmy doskonali. Posiadanie takiej myśli z tyłu głowy – zwłaszcza jeżeli budujesz coś, co będzie miało wpływ na życie wielu ludzi – jest naprawdę ważne.

Jak widzisz rolę sztuki i swoją rolę jako artystki w eksplorowaniu tematu sztucznej inteligencji?

Widzę dwa główne nurty w sztuce związanej z SI. Pierwszy reprezentują artyści, którzy używają tej technologii do tworzenia prac, na przykład algorytmicznych obrazów – to jest niezwykle interesujące i generuje wiele pytań dotyczących autorstwa i prawa autorskiego. Drugi – do którego należę między innymi ja – skupia twórców, którzy traktują sztukę jako narzędzie do dyskutowania o sztucznej inteligencji. Ich prace, które często powstają bez użycia jakichkolwiek nowych technologii, mają konfrontować szeroką publiczność ze społecznymi, filozoficznymi i kulturowymi kwestiami, które, w związku z rozwojem SI, wymagają przemyślenia na nowo.

Wszyscy naokoło mnie wciąż rozmawiają o nowych technologiach, ale większość ludzi nie spędza życia w środowisku akademickim ani nie ma dyplomu studiów informatycznych. Nie biorą udziału w tej debacie i to ją niezwykle ogranicza. Ludzie, którzy nie są zawodowo związani z rozwojem sztucznej inteligencji, nie czują się uprawnieni do zabierania głosu w tej sprawie. A przecież istnieje wiele ważnych, jednocześnie przystępnych pytań dotyczących społecznych i kulturowych aspektów SI. Celem mojej pracy jest przekonanie ludzi, że ich opinia ma znaczenie i że wcale nie muszą rozumieć wszystkich technicznych detali związanych z danym zagadnieniem, żeby mieć zdanie na temat możliwych konsekwencji wprowadzenia ich w życie.

Tekst dostępny na licencji Creative Commons BY-NC-ND 3.0 PL (Uznanie autorstwa-Użycie niekomercyjne-Bez utworów zależnych).