Banki danych to encyklopedie jutra. Zwiększają potencjał każdego użytkownika. Są częścią „natury” postmodernistycznego człowieka.

Jean-François Lyotard, „Kondycja ponowoczesna: raport o stanie wiedzy”

Wielkie bazy danych czyhają na twoje książki. Z całą resztą już sobie poradziły. Wszelkie ludzkie działania przyjmują dziś formę nieprzebranego strumienia danych, penetrowanego przez automaty poszukujące znaczeń. Mądra książka pod głupim tytułem „Automate This” [Zautomatyzuj to] Christophera Steinera oferuje fascynujący wgląd w nową kulturę, opartą na algorytmach: sześćdziesiąt procent transakcji rynkowych obywa się bez ludzkiego nadzoru, sztuczna inteligencja doprowadziła do zmian w opiece medycznej, muzyce rozrywkowej, baseballu, systemach wyborczych, wpłynęła również na kilka aspektów prawa. A teraz, jak zwycięska armia, która podbiwszy Włochy, przypomniała sobie o San Marino, algorytmy rozpoczęły spóźniony atak na literaturę.

Opowieść o tym, jak literatura zmieniła się w dane, to przede wszystkim historia kilku, ściśle ze sobą powiązanych intelektualnych pomyłek.

W 2002 roku Larry Page postanowił wykończyć książki w takiej formie, w jakiej je dotychczas znaliśmy. Współpracując z wiceprezydentką Google, Marissą Mayer, przeznaczył dwadzieścia procent swojego czasu pracy – które inżynierowie Google mogli wtedy wykorzystywać na projekty własne – na opracowanie maszyny zamieniającej książki w strumień danych. Pierwsza wersja była prostym urządzeniem ze sklejki, wyposażonym w szczypce, metronom, skaner i ostrze do rozcinania książek. Cały proces skanowania zajmował 40 minut. Wykazując się czułoscią wobec drukowanych książek, Page bardzo szybko opracował modyfikację pozwalającą na digitalizowanie tekstów bez rozcinania grzbietów skanowanych tomów. Zbudowano kamerę na podczerwień, zdolną zniwelować krzywiznę tekstu. Inżynierowie Page’a wskrzesili również zapomniane oprogramowanie do optycznego rozpoznawania tekstu (OCR), stworzone przez firmę Hewlett-Packard i udostępnili je na wolnej licencji, pozwalając użytkownikom na jego modyfikację. Dzięki wykorzystaniu rewelacyjnego oprogramowania reCAPTCHA udało się zminimalizować koszty korekty zeskanowanego tekstu. Było to niezwykle sprytne posunięcie: wszyscy, którym zdarzyło się wprowadzić kod weryfikacyjny CAPTCHA, biorą udział w udoskonalaniu światowej biblioteki, choć najczęściej sami o tym nie wiedzą. Do współpracy przystąpiło błyskawicznie pięć największych bibliotek na świecie i tak oto literatura zmieniła się w dane.

Reakcje

Opublikowany na łamach „Los Angeles Review of Books” esej Stephena Marche’a „Literatura to nie dane: przeciw cyfrowej humanistyce” wywołał burzliwą dyskusję w Stanach Zjednoczonych i liczne reakcje, wiele z nich krytycznych. Publikujemy dwie z nich: autorstwa Scotta Seliskera literaturoznawcy z Uniwersytetu Arizony oraz Holgera Schotta Syme'a historyka teatru i literatury z Uniwersytetu Toronto.

A raczej w potencjalne dane. Pojawił się bowiem problem zbyt złożony dla Page’a i jego ćwiczonych w rozplątywaniu zawiłości współpracowników: opór świata literatury. Proces wytoczony firmie Google przez Amerykańską Gildię Pisarzy oraz Stowarzyszenie Wydawców był zjawiskiem równie ważnym, choć o wiele mniej nagłośnionym, co rozprawa w sprawie obsceniczności „Kochanka Lady Chatterley” D.H. Lawrence’a. Literaci zwarli szeregi, próbując dać odpór otwartości głoszonej przez rzetelnych inżynierów. Zamiast ucieszyć się z daru digitalizacji i możliwości nieodpłatnego udostępnienia klasycznych dzieł olbrzymiej rzeszy czytelników, ludzie pióra i bibliotekarze natychmiast zabrali się do tego, co potrafią najlepiej: jałowego, wyniszczającego ględzenia.

Słuchanie tych bredni to największy błąd popełniony przez Google. Osiągnięcie porozumienia było równie prawdopodobne, jak dogadanie się ze stadem wróbli. Google mogło przecież zawrzeć umowę z największymi bibliotekami świata i dzięki wykorzystaniu prawa dozwolonego użytku udostępnić instytucjom publicznym wyszukiwarkę Book Search, a potem odsunąć się na bok.

Źródłem problemu jest wrodzona bojaźliwość leżąca u podstaw świata literatury i jego instytucji. Kultura masowa zasypuje nas wizerunkami profesorów i pisarzy jako hedonistów, liberałów i ekscentryków, trudno jednak znaleźć równie konserwatywnych z natury ludzi, jak autorzy i badacze literatury. Te same antytechnologiczne tendencje, jakie możemy dzisiaj zaobserwować, towarzyszyły też narodzinom druku. „Pochwała skrybów” autorstwa wielkiego niemieckiego uczonego, Johannesa Trithemiusa to jeden z najczęściej przytaczanych przykładów oporu pisarzy przeciwko nowej technologii. Pojawiło się w niej kilka rozsądnych argumentów: manuskrypty były o wiele piękniejsze niż druk, a ręczne kopiowanie tekstów pozwalało na korektę i eliminację błędów. Sam proces pisania był istotny duchowo. Niemiecki uczony wspomina pewnego skrybę, który przepisywał z takim oddaniem, że zrosły mu się palce. Problem w tym, że pierwsze wydanie „Pochwały skrybów” ukazało się drukiem. Pomimo niechęci wobec nowoczesności Trithemius starał się dotrzymać jej kroku.

Zmiany zapoczątkowane przez Google Books są na swój sposób bardziej rewolucyjne niż wynalazek prasy drukarskiej. Następuje zerwanie z formą kodeksu, towarzyszącą nam mniej więcej od czwartego wieku naszej ery. Zszywanie kilku tekstów w jedną całość, by umożliwić ich przenoszenie, było jednym z pierwszych wynalazków chrześcijaństwa. W starożytnym Rzymie korzystano z pojedynczych zwojów. Gwałtowny sprzeciw bibliotekarzy, pisarzy i naukowców, wywołany planami uwolnienia literatury od formy kodeksu, nie jest spowodowany jedynie dbaniem o własne interesy. Wielu z nich widzi w tym prawdziwe świętokradztwo, powrót do pogańskich czasów i zachowań.

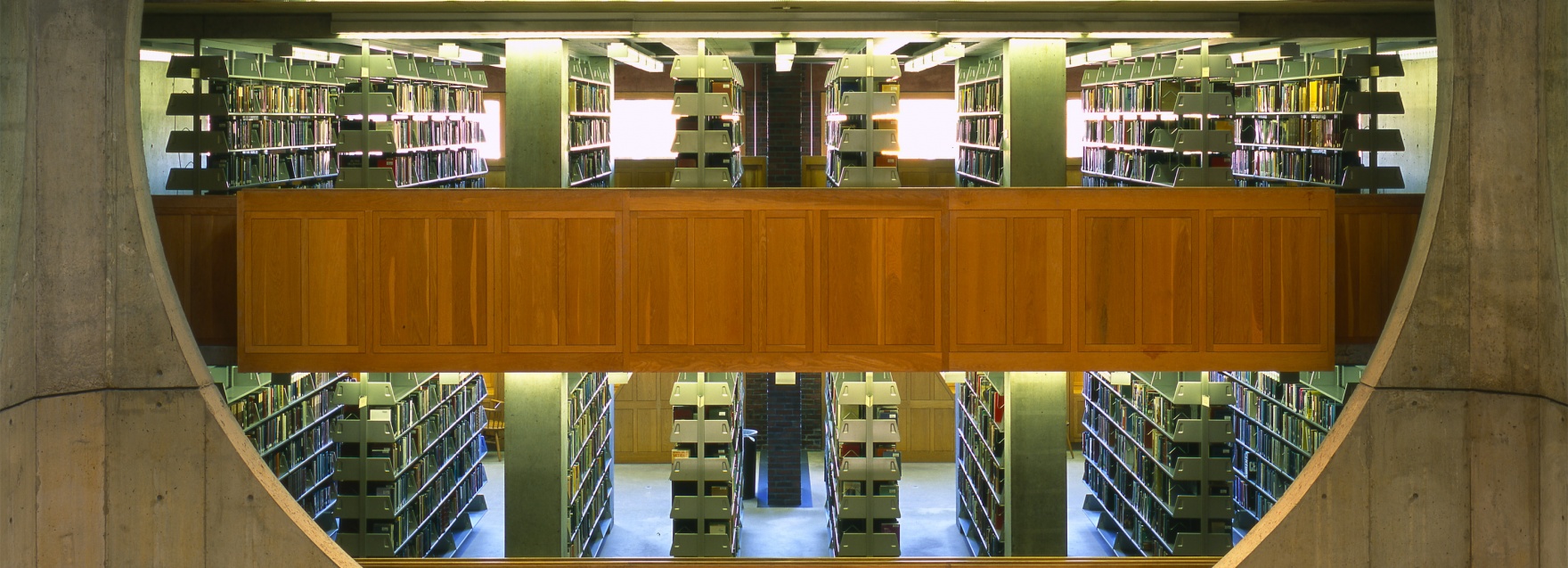

Wciąż oczywiście działają setki projektów digitalizacyjnych. Jednym z przykładów jest zbiór Early English Books Online, który istnieje już od dekady. To wspaniała baza danych, pokazująca, w jaki sposób digitalizacja doprowadziła do upadku sacrum. Przed jej powstaniem każdy badacz angielskiego renesansu musiał odbyć wyprawę do Oksfordu – to właśnie tam, w Bibliotece Bodlejańskiej, dostępne były wszystkie materiały. Poszukiwanie tekstów stanowiło jednak tylko część procesu, wizyta w bibliotece była także okazją do nawiązania kontaktów. Staroświeccy profesorowie częstowali się przy obiadach tabaką i porto. Publikacja zbiorów EEBO w sieci sprawiła, że to wszystko zniknęło, odwiedziny w bibliotece stały się zbyteczne.

Desakralizacja literatury dokonuje się również dzięki stylometrii, analizie wzorców stylu literackiego. Do jej największych sukcesów zalicza się odkrycie, że Thomas Middleton był współautorem szekspirowskiego „Tymona Ateńczyka”. Ofiarą tej metody badawczej padła jedna z największych świętości literatury: legenda unikatowego, mitotwórczego geniuszu Szekspira.

Stworzone pod egidą Erazma i innych uczonych nauki humanistyczne pojawiły się u zarania ery druku, by pomóc w rozpowszechnianiu klasycznych tekstów, które wyszły poza mury klasztorów i trafiły w ręce świeckich. Dziś, u progu ery internetowej, Google opisuje swój projekt jako próbę „wszechstronnego upowszechnienia użytecznych informacji”. Akademicy mogli postąpić zgodnie z odwieczną misją humanizmu: udostępnić i objaśnić jak największą liczbę tekstów. Dzięki uprawomocnieniu działań Google mogliby pomóc w zrozumieniu historycznych kontekstów literackich, tradycji i standardów naukowych. Niestety, wymagałoby to zabrania się do uczciwej pracy. O wiele łatwiej tkwić w starych modelach publikacji, zapewniających bezpieczną nieistotność, czy też jak to ujął Kingsley Amis: „naświetlać nieistniejące problemy”. W końcu od co najmniej półwiecza nauki humanistyczne skupiają się raczej na tworzeniu kolejnych problemów niż ich rozwiązywaniu.

Stworzone pod egidą Erazma i innych uczonych nauki humanistyczne pojawiły się u zarania ery druku, by pomóc w rozpowszechnianiu klasycznych tekstów, które wyszły poza mury klasztorów i trafiły w ręce świeckich. Dziś, u progu ery internetowej, Google opisuje swój projekt jako próbę „wszechstronnego upowszechnienia użytecznych informacji”. Akademicy mogli postąpić zgodnie z odwieczną misją humanizmu: udostępnić i objaśnić jak największą liczbę tekstów. Dzięki uprawomocnieniu działań Google mogliby pomóc w zrozumieniu historycznych kontekstów literackich, tradycji i standardów naukowych. Niestety, wymagałoby to zabrania się do uczciwej pracy. O wiele łatwiej tkwić w starych modelach publikacji, zapewniających bezpieczną nieistotność, czy też jak to ujął Kingsley Amis: „naświetlać nieistniejące problemy”. W końcu od co najmniej półwiecza nauki humanistyczne skupiają się raczej na tworzeniu kolejnych problemów niż ich rozwiązywaniu.

Podsumowując to wszystko, łatwo stwierdzić, że proces przemiany literatury w dane potoczył się fatalnie, a wróżby przed rozpoczęciem drugiego etapu, kiedy musimy zdecydować, co począć z tymi danymi, są jak najgorsze.

Samo określenie „cyfrowa humanistyka” wywołuje przyjemny dreszczyk podniecenia, połączony z poczuciem uczestnictwa w komedii omyłek. Doskonały obraz tej początkowej euforii znajdziemy na blogu Williama Pannapackera, piszącego dla „The Chronicle of Higher Education”:

W przygnębiającej atmosferze dominującej podczas konferencji Modern Language Association w 2009 roku, tylko jedna dziedzina zdawała się promieniować żywotnością: cyfrowa humanistyka. Co ważniejsze, to właśnie ona, spośród wielu innych metod badawczych, została uznana za tak długo wyczekiwany „wielki przełom” w naukach humanistycznych.

Oto, czym jest cyfrowa humanistyka: „kolejnym wielkim przełomem”. Pod tą nazwą może się skrywać wiele rzeczy: od powierzchownej znajomości współczesnych technologii, jak u wykładowcy literatury, zdającego sobie sprawę z istnienia Twittera, po świadomość, że są lepsze metody rozpowszechniania tekstów akademickich niż publikacja w magazynach naukowych, kurzących się na zapomnianych bibliotecznych półkach. Cyfrowa humanistyka stworzyła również kilka wartościowych nisz badawczych, takich jak analiza awangardowej literatury cyfrowej czy też wpływu współczesnych procesorów tekstu na techniki pisarskie. Są to ważne pola badawcze, ale ich zasięg jest z natury ograniczony.

Jedną z najbardziej obiecujących ścieżek badawczych, przynajmniej na pierwszy rzut oka, wydaje się być „czytanie z oddali” (distant reading) – metoda zaproponowana już ponad dekadę temu przez Franco Morettiego z Uniwersytetu Stanforda (gromadzenie i analiza dużych zbiorów danych dotyczących tekstu literackiego, np. słownictwa, składni, przeciwieństwo close reading, czyli czytania konkretnych tekstów – przyp. red.). Potencjalnie twórcza może być też ekstrakcja danych (data mining), choć raczej z powodu zmiany podejścia do literatury niż faktycznych odkryć. To dzięki tej metodzie filologowie mogli stworzyć wnikliwe, skalowalne n-gramy (statystyczne modele językowe), pozwalające przewidywać sekwencje słów. Problem zaczyna się dopiero wtedy, gdy chcemy zastosować uzyskane dzięki modelom uogólnienia do rozwikłania istotnych kwestii literackich. Opublikowany niedawno na łamach „The Proceedings of the National Academy of Science” artykuł: „Wzory ilościowe wpływów stylistycznych na ewolucję literatury”, z którego wynikało, że współcześni pisarze są o wiele mniej zaznajomieni z klasyką, niż ich twórcy z wcześniejszych epok, został momentalnie wyszydzony przez badaczy literatury i media.

Łatwo to zrozumieć. Nawet powierzchowna analiza fundamentalnych założeń użytych w tej dyskusji, odsłania nieprecyzyjność słów skrywających się pod równaniami. Czym jest „klasyka”? Na czym polega „wpływ”? Czy podobieństwo języka to najlepszy sposób na ustalanie podobieństw między pisarzami? A problemem „czytania z oddali” okazuje się, oczywiście, osiągnięcie dystansu właśnie.

Kłopot z cyfrową humanistyką sięga jednak o wiele głębiej, do pierwotnych założeń tej metodologii, które wciąż nie znalazły wystarczającego teoretycznego potwierdzenia. Literatura nie może być traktowana jako zbiór danych. Literatura to przeciwieństwo danych. Zbiory danych poprzedzają literaturę. Pierwsze sumeryjskie teksty to zamówienia na piwo i owies. Ale już pierwsza spisana opowieść, „Epos o Gilgameszu”, to historia „człowieka, który spojrzał w otchłań”, bohatera, który natknął się na coś nieopisywalnego. Najstarsze dzieło literackie, które dotrwało do naszych czasów, opowiada o rzeczach, których nie sposób przekształcić w informację, a co za tym idzie w dane. Jedną z podstawowych przeszkód jest nieodwracalna niekompletność literatury. Można zgromadzić wszystkie statystyki sportowe. Można zapisać każdą transakcję giełdową. Można rozpoznać wszystkie kombinacje i permutacje układu figur na szachownicy. Jesteśmy w stanie zbudować nawet taką bazę danych, która będzie zawierała wszystkie zapisy prawa obowiązujące na świecie. Ale nie da się poznać całości literatury, nie da się nawet poznać całości literatury w języku angielskim. Jej olbrzymie fragmenty zaginęły bezpowrotnie lub pozostały po nich jedynie cząstki.

Literatura od zawsze jest skazana na niepamięć, na postępujący rozkład. To, co wiemy o przeszłości, jest prawie zawsze fragmentaryczne. Brakuje nam olbrzymich ilości danych, wielu rzeczy nadal nie potrafimy rozwikłać. Jednym z najbardziej oczywistych przykładów jest oczywiście Szekspir. Istnieje dziewięć wersji „Ryszarda III” oraz trzy wersje „Hamleta”, każda ma zmienione, dodane lub usunięte fragmenty. Wiemy także o zaginionych sztukach: „Cardenio”, „Love’s Labour Won”. Nie ma po nich śladu. Mimo wysiłków pokoleń badaczy, którzy przez wieki pochylali się nad dorobkiem Szekspira, jego twórczość nigdy nie zostanie w pełni opisana. Literatura jest bezpowrotnie zabałaganiona i pełna luk. I to właśnie stanowi o jej humanizmie.

Pierwotnym literackim uczuciem jest doświadczenie tajemnicy języka. Obfitość literatury antycznej – prostota i tajemniczość Safony, tragizm błądzącego Edypa – wynika z olbrzymiego zachwytu odkryciem, że słowa niosą ze sobą taką wielość znaczeń. Patrząc na dowolne zdanie tekstu literackiego, natychmiast rozumiemy, jak nieuchwytna jest zawarta w nim informacja. Weźmy mój ulubiony cytat z szekspirowskiego „Makbeta”: „Światło gęstnieje; kruk ciągnie do gawroniego lasu”. Jaka jest różnica między krukiem a gawronem? Żadna. Co oznacza, że „światło gęstnieje”? Któż to wie? Jako dane ten wers nie ma praktycznie żadnego znaczenia, rzuca jednak olśniewające światło na sytuację bohaterów.

Jeszcze więcej problemów nastręcza kontekst. „Czytanie z oddali” jest czymś nowym tylko wtedy, jeśli całkowicie zerwiemy z tradycyjnymi modelami pojmowania przeszłości. Największą zaletą w algorytmicznej analizie wielkich zbiorów danych jest demokratyczny duch unoszący się nad tym przedsięwzięciem. Tym, co najbardziej podnosi na duchu w czasie lektury czasopism poświęconych cyfrowej humanistyce, jest inżynierska postawa autorów. Choć wychodzą z całkowicie błędnych moim zdaniem założeń, zachowują otwartość umysłu i szczerze mówią o ograniczeniach wynikających z obróbki danych oraz o tym, co dzięki temu można osiągnąć. Jest to niezwykle odświeżające podejście. Niestety, ta metoda wymusza traktowanie literatury jako jednorodnej masy. Matematyczna analiza powieści i tekstów prasowych sprowadza się do redukcji. Proces przekształcania literatury w dane niweluje wszystkie różnice, gusta i subtelności. Całą historię danego dzieła. „Do latarni morskiej” Wirginii Woolf staje się tylko kolejną powieścią w nieprzebranym ich stosie.

Potwierdza to już Borges, podobnie zresztą jak wiele innych trendów współczesności. Jego opowiadanie „Pierre Menard, autor Don Kichota” można odczytywać jak polemikę z podstawowymi założeniami cyfrowej humanistyki. Główny bohater postanawia w nim raz jeszcze napisać cały tekst Don Kichota – nie przeróbkę, nie transkrypcję, tylko dokładnie ten sam tekst, tak jakby był dziełem współczesnego autora. Dane w obu tekstach są identyczne. Ich znaczenia – całkowicie odmienne.

Konsekwencje traktowania literatury jako przeciwieństwa danych wykraczają poza dość nieistotny rezerwat badań literackich. Odległość dzieląca stwierdzenie „algorytmy wykazały, że nie polubisz tej muzyki” od stwierdzenia „to obiektywne prawo, nie możesz się z nim nie zgadzać” jest niewielka. Algorytmy zastąpiły ludzkie prawa, różnica polega na tym, że nikt ich nie rozumie. Opisują znaczenie naszych zachowań, choć same są pozbawione wszelkich znaczeń.

To właśnie dlatego algorytmy działają doskonale, dokładnie tak jak faszyzm, niosąc ze sobą poczucie nieuchronności. Aż do chwili, kiedy zupełnie przestają się sprawdzać. W czasie błyskawicznego krachu giełdowego, do jakiego doszło 6 marca 2010 roku, indeks Dow Jonesa w ciągu pięciu minut stracił dziewięć procent wartości. Ostatnio firma Knight Capital pozbyła się czterystu czterdziestu milionów dolarów, tracąc około dziesięciu milionów na minutę z powodu „wrogiego algorytmu”. Żaden algorytm nie może być wrogi, to oczywiste. Ale tym właśnie słowem określa się algorytmy, które wymknęły się spod kontroli, innymi słowy – te, których twórcy nie wiedzieli, co robią. Przed utratą milionów Knight Capital wykorzystywało metody naukowe do zrozumienia praw rządzących rynkiem. Udało im się całkowicie zniwelować ryzyko, nieodłączny składnik ludzkiej natury. 45 minut później okazało się, że nic z tego. Jak pisał Borges: „Każdy wysiłek umysłu, poddany ostatecznej analizie, okazuje się bezużyteczny. Należy pamiętać, że ta sama nieskuteczność nawiedza zarówno modelowanie matematyczne, jak i próby kontekstualizacji literatury”.

Znaczenia są płynne. Rozpadają się. Bywają paskudne, bo rodzą się ze słabości i porażek. Podobnie jak ludzkie ciało, mają wiele szczelin i mogą paść ofiarą chorób. Życie z nimi wymaga odwagi i pogodzenia się z pewnym stopniem nieczystości. Nawet jeśli bardzo tego pragniemy, nie ma już odwrotu od niezawodnych maszyn. Pozwoliliśmy na to, by rozcięto księgi, rzuciliśmy światową klasykę na pastwę wiatru. Musimy ją jakoś pozbierać z powrotem. Ale możliwość stworzenia natychmiastowo dostępnej, opracowanej przez fachowców i zupełnie bezpłatnej światowej biblioteki, to coś więcej niż marzenie. Dzięki perfekcji naszych niezawodnych maszyn już wkrótce zawsze i wszędzie będziemy mieli dostęp do każdego tekstu na świecie.

Ale ich zrozumienie pozostaje w naszej gestii.

Przekład MS

Cykl tekstów dotyczących kultury cyfrowej powstaje we współpracy z Centrum Kompetencji ds. Digitalizacji Narodowego Instytutu Audiowizualnego.

Artykuł pochodzi z „Los Angeles Review of Books” (wydanie z 28 października 2012).