W 1998 roku Google indeksowało 26 mln stron internetowych, w 2000 roku było ich już ponad miliard. W 2008 roku liczba indeksowanych adresów URL przekroczyła 1 bilion (1012), dziś jest to… zresztą jakie to ma znaczenie? Rzecz nie w liczbach, ale w zmianie jakościowej. Wystarczy spojrzeć na World Wide Web, najbardziej dostępną i efektowną spośród warstw internetu, która już dziś jest zjawiskiem historycznym. Jednak Web może stawać się historyczny tylko dzięki wysiłkom inicjatyw archiwizacyjnych, zabezpieczających i udostępniających stare wersje stron internetowych.

Bezpowrotnie utracona chropowatość

Web znika dziś razem z przeglądarką. Czy zauważyliście, że z każdym miesiącem ma on coraz mniej i mniej przycisków? Że jego ramy z tygodnia na tydzień stają się coraz cieńsze? Czy zauważyliście, że od jakiegoś czasu nie możecie zobaczyć nazw plików w pasku adresowym przeglądarki waszego smartfona? Coraz mniej tego wszystkiego… Web znika, ponieważ go nie projektujemy, nie budujemy, jedynie publikujemy w przygotowanych wcześniej formatach

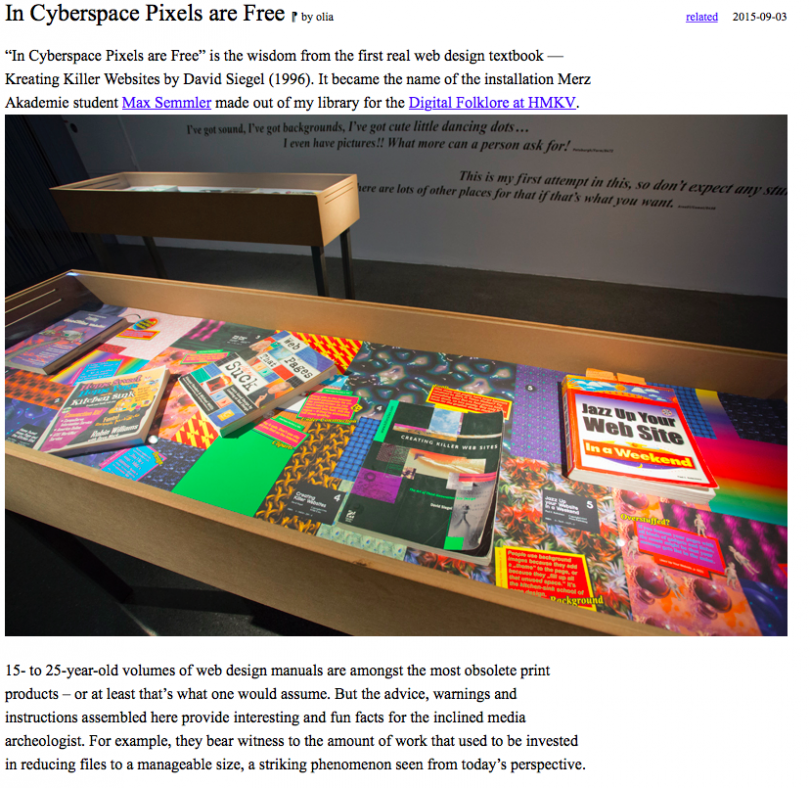

– pisała Olia Lialina, jedna z pionierek netartu, wykładająca obecnie na Merz Akademie w Stuttgarcie, twórczyni projektu archiwalnego Jeden Terabajt z Ery Kilobajtów (One Terabyte of Kilobyte Age). Zmianę najłatwiej zauważyć, gdy przyjrzy się oddolnej produkcji cyfrowej: niezwykłe i zróżnicowane zasoby prywatnych stron domowych publikowanych dawno temu na GeoCities czy pierwszej fali blogów ustępują formatowanej i standaryzowanej przez Facebooka czy Instagrama webowej produkcji. To proces, który domaga się opisania w jakimś podręczniku historii Internetu.

Zrzut ekranu ze strony http://blog.geocities.institute/

Zrzut ekranu ze strony http://blog.geocities.institute/

Uruchomiony w 1994 roku serwis GeoCities pozwalał każdemu na założenie i prowadzenie prostej strony domowej. W istotny sposób obniżał barierę wejścia do sieci tym, którzy nie posiadali twardych kompetencji programistycznych. Utrzymywane od 1999 roku przez Yahoo! wirtualne miasta zasiedlili fani fantastyki, zwolennicy teorii spiskowych, amatorscy pisarze czy po prostu ludzie, którzy chcieli jakoś zaistnieć online. Budowane chałupniczą metodą strony były świadectwem pierwszej fali cyfrowej demokratyzacji, w ramach której każdy uzyskiwał szansę na bycie częścią globalnego internetu. Kiedy w 2009 roku Yahoo! zamykało serwis, wciąż istniało tam 38 mln stron domowych. Wszystkie one miały zniknąć, ustępując pola nowym formom obecności online. W lutym 2010 roku Facebook miał już ponad 400 mln użytkowników.

Część zasobów porzuconej przez właścicieli cyfrowej infrastruktury GeoCities została skopiowana i zabezpieczona przez kolektyw cyfrowych archiwistów i archiwistek, działający pod kierunkiem Jasona Scotta Sadofsky'ego, pracownika fundacji Internet Archive. W 2010 roku udostępnili oni na torrentach archiwum o objętości 629 GB. To właśnie na tym archiwum pracuje Olia Lialina. Dzięki niezależnym działaniom Archive Team, a także staraniom fundacji Internet Archive czy poszczególnych krajowych instytucjonalnych programów archiwizacyjnych można mówić o tym, że sieć ma historię. Bez tych działań byłaby to tylko opowieść bez źródeł, coś w rodzaju nostalgii, która nigdy nie dałaby podstaw do badań. Zamiast cyfrowych artefaktów pozostałyby jedynie strzępki relacji i pojedyncze screenshoty, tak jak w przypadku powstałego w 1994 roku Digital City – pierwszego holenderskiego serwisu społecznościowego, którego rekonstrukcji podejmuje się dziś inicjatywa DDSII organizowana przez Amsterdam Museum.

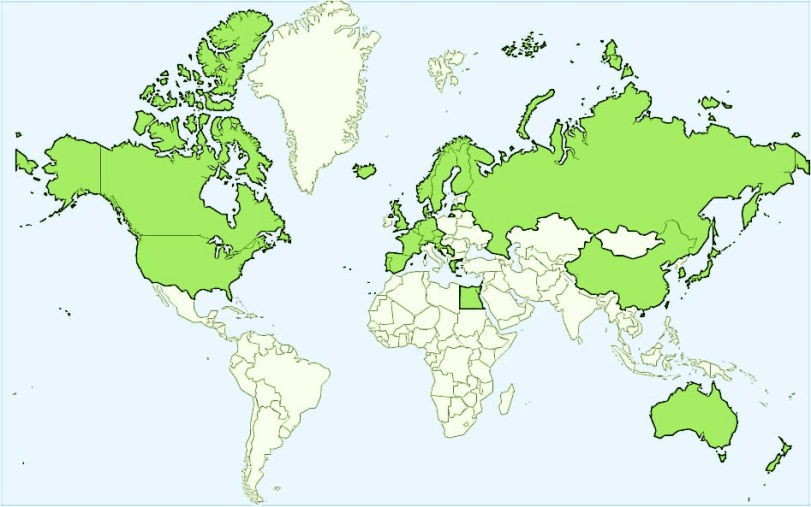

Mapa inicjatyw archiwizacji internetu/Wikipedia/Adnarimiranda CC BY-SA 3.0

Mapa inicjatyw archiwizacji internetu/Wikipedia/Adnarimiranda CC BY-SA 3.0

API do przeszłości i sformatowany Web

Kiedy dziś Web centralizuje się wokół Facebooka czy Google'a, tracąc swoją chropowatość i zróżnicowanie na rzecz wymuskanego streamu, jego archiwizowanie oznacza konieczność współpracy z dominującymi platformami. Nie jest to jednak współpraca partnerska, a raczej relacja klienta wobec dostawcy, wyznaczana przez wątłe uprawnienia użytkownika API wobec wszechwładzy administratora. Dostawca na własnych warunkach decyduje o tym, co można, a czego nie można zobaczyć, pobrać, skopiować i archiwizować. Dominacja centralnych platform ujawnia się i wówczas, kiedy archiwizować chcemy własne zbiory cyfrowe: kluczowa jest tu nasza podmiotowość i wolność działań w ramach wykorzystywanej chmury, w której publikujemy i gromadzimy cyfrowe fotografie, stare pliki multimedialne, maile, dokumenty.

Chcielibyśmy zapobiec sytuacji, w której archiwa kultury służyć będą jako tło dla reklam lub jako wykorzystywana do profilowania pułapka na użytkowników i dlatego musimy podjąć wysiłek, aby zbudować sobie własną infrastrukturę

– czytamy w manifeście kolektywu Active Archives. Dopiero kontrola nad infrastrukturą ma pozwalać na jakąś podstawową autonomię. Skutki jej braku pokazuje przypadek projektu Politwoops. Jego celem było archiwizowanie i udostępnianie publikowanych przez polityków i urzędników, a następnie z różnych powodów kasowanych tweetów. Arbitralna decyzja władz Twittera doprowadziła do upadku ważnej społecznie inicjatywy, mającej na celu kontrolowanie komunikacji politycznej online.

Jednak siłą kształtującą historyczność Webu są dziś nie tylko wielcy gracze, ale też konkretne rozwiązania techniczne, które w istotny sposób ograniczają zasób treści mogących podlegać archiwizacji. Web formatowany pod szablony fanpage’y Facebooka czy pod popularne frameworki, takie jak Twitter Bootstrap, mocno komplikuje działania archiwalne. Wynika to z niezwykłej zmienności, będącej rezultatem dominacji JavaScript i myślenia o stronie internetowej jako płynnej prezentacji, w której nie istnieje stan biernego spoczynku, a jedynie niekończące się przewijanie. Tego typu treści trudno archiwizować i publikować w wersjach historycznych przy jednoczesnym zachowaniu przynajmniej części ich dynamicznego charakteru. Kiedy robot indeksujący kopiuje poszczególne podstrony archiwizowanych serwisów i tworzy ich wersje archiwalne, nie jest w stanie tworzyć kopii odpowiadającej 1:1 pierwotnej wersji zasobu.

Oś czasu

Już prawie dziesięć lat temu Julien Masanés, obecnie dyrektor Internet Memory Foundation, sprawnie podważył odwołujące się do racjonalności argumenty przeciwko archiwizacji Webu. Po latach ułudy wiecznego teraz i niemyślenia o tym, że internet może być w ogóle historyczny, przeszliśmy do etapu gorączkowych starań o zabezpieczenie jak największej liczby historycznych zbiorów webowych, a archiwum i pamięć stały się w kontekście komunikacji cyfrowej pojęciami zdecydowanie pozytywnymi.

Ogromną przeszkodą dla kultury są również w wielu okolicach podzwrotnikowych małe termity, czyli comeje. Pożerają przeraźliwie wszystko, papier, tektury, pergamin, niwecząc całe archiwa i biblioteki. W licznych prowincjach hiszpańskiej Ameryki nie ma pisanego dokumentu starszego nad sto lat. Cóż się ma tedy stać z kulturą danego kraju i ludu, jeśli przeszłość nie będzie złączona z chwilą bieżącą i trzeba ponawiać walki i klęski, okupując tym na nowo doświadczenie?

– pisał w „Podróży po rzece Orinoko” Alexander von Humboldt. Ponad sto lat później trudno już wierzyć w wychowawczą rolę historii, a miejsce złośliwych termitów zajęły rozmaite przejawy cyfrowej entropii. Problemy z odczytywaniem starych formatów plików, niedostępne skrzynki poczty elektronicznej, błędy w kopiowaniu czy martwe linki to oczywiste dowody na to, że i kulturze cyfrowej grozi zapomnienie.

Nie jest to jednak oderwane od naszych osobistych, ale też pewnie w jakimś stopniu pokoleniowych doświadczeń. Upadające czy zmieniające się nieustannie serwisy internetowe, tak jak starzejące się e-maile na coraz bardziej zapchanych kontach pocztowych czy kolejne aktualizacje oprogramowania przypominają nam o naszej własnej historyczności. Archiwa Webu, ale też archiwa starych gier czy muzea sprzętu komputerowego, nie tylko stanowią warunek prowadzenia badań nad historią kultury cyfrowej, ale przede wszystkim dają jej świadectwo. Czas nieubłaganie gna do przodu, a technika cyfrowa – mimo obietnic nieustannej teraźniejszości – wciąż nie potrafi nas uchronić od doświadczenia przemijania.

Tekst dostępny na licencji Creative Commons BY-NC-ND 3.0 PL (Uznanie autorstwa-Użycie niekomercyjne-Bez utworów zależnych).