Aiko i Kenji

Każdy, kto interesuje się cyborgami i robotami, musiał przeszukując sieć natrafić na Aiko. Jest obleczona w silikonowe ciało, waży 30 kilogramów, mierzy 152 cm i jest kobietą-androidem, stworzonym przez kanadyjsko-wietnamskiego konstruktora Le Trunga. Rozmawia po angielsku i japońsku, sprząta, myje okna, odkurza. Czyta książki i rozróżnia kolory, uczy się i zapamiętuje. Jeśli ktoś ją szarpnie za rękę, wyrywa ją i oznajmia, że ten dotyk nie był przyjemny. Gdy Le Trung próbował ją publicznie pocałować, uderzyła go w twarz. Niezrażony, a wręcz zachwycony jej zachowaniem konstruktor mówi o niej na przemian jako o swojej partnerce-żonie, dziecku lub jako projekcie, czymś, co chciałby po sobie pozostawić dla potomnych.

PIĘKNA PORAŻKA

Dlaczego fascynuje to, co nieudane, wykolejone? Wspaniała katastrofa, wzniosły upadek, piękna porażka. Koło zamachowe nauki, kultury i sztuki. Zderzenie wyobraźni i rzeczywistości. Niepowodzenie intryguje bardziej niż banalność sukcesu, a jedna rzecz niezaistniała bywa większa niż wszystko, co świat ma do zaoferowania.

Iwona Kurz opowiada o Polsce post-Wajdowskiej, Maria Poprzęcka o artystach bez dzieł; Agnieszka Berlińska rozmawia z fotografującym stocznię Michałem Szlagą, Paweł Soszyński o porażkach w teatrze z Małgorzatą Dziewulską, a Jakub Socha o futbolu z trenerem Łukaszem Smolarowem; Maciej Stasiowski analizuje „The Falls” Greenawaya, a Bartosz Sadulski losy Roberta Walsera; Aleksandra Przegalińska przywołuje historie nieudanych robotów, Ludwika Mastalerz nieudane rewolucje naukowe, a Jan Gondowicz pewną młodzieńczą przygodę Witkacego; Agnieszka Mirahina pisze o językach porażki, Andrzej Szpindler zaś o porażkach bułki kajzerki. Rysuje Maciej Sieńczyk.

Konstruktor zapewnia, że chce w ciągu najbliższych kilku lat doprowadzić ją do stanu, w którym będzie jak najbardziej ludzka. Z korzyścią dla niego samego – bo jest jego towarzyszką życia, oraz dla potomnych – to jeden z niewielu tak zaawansowanych androidów, który został skonstruowany metodami półchałupniczymi. Aiko nie umie jednak czegoś, co dla sprawnego człowieka jest proste i oczywiste – chodzić. Robot porusza się na wózku inwalidzkim. Nie tylko dlatego, że Le Trunga nie stać na sfinansowanie oprogramowania do chodzenia. Głównie dlatego, że aktualna konstrukcja Aiko nie jest kompatybilna z żadnym oprogramowaniem do chodzenia, które by jej nie ośmieszało. Le Trung musiałby wymienić Aiko na lepszy model. Wtedy zaś utraciłaby to, czego do tej pory jej uczył.

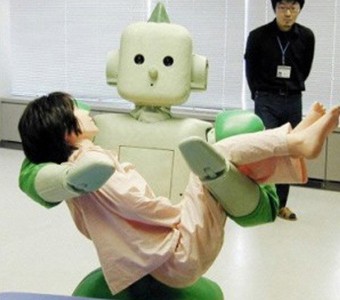

Szukając dalej przykładów, uważny zainteresowany natknie się na Kenjiego. Kenji należy do grupy robotów, którym wszczepiono niestandardowe oprogramowanie, umożliwiające emocjonalne reagowanie na bodźce zewnętrzne. Za ogromny sukces twórcy Kenjiego uznali wyrazy jego oddania dla lalki, którą zgodnie z instrukcjami zawartymi w programie miał obejmować co godzinę. Gdy lalka znikła, Kenji dopytywał się, gdzie jest i kiedy do niego wróci. Naukowcy – zbudowani empatyczną postawą – odtrąbili sukces w zbudowaniu pierwszej czującej maszyny. I rzeczywiście, dzięki samodzielnej wielotygodniowej iteracji zachowań opartych na złożonym kodzie Kenji wyposażył się w coś, co z grubsza można by określić jako uczucie czułości. Opiekunów cieszyły jego postępy do momentu, gdy czułość zaczęła być groźna. Kenji zademonstrował poziom przywiązania właściwy psychopacie.

Kenji, źródło: http://uk.ign.comWszystko zaczęło się pewnego dnia, gdy w laboratorium pojawiła się młoda studentka, której zadaniem było testowanie nowych procedur i rozszerzanie oprogramowania Kenjiego. Dziewczyna regularnie spędzała z nim czas. Kiedy jednak nadszedł dzień końca jej stażu, Kenji zaprotestował w sposób dość dosadny: nie pozwolił jej opuścić laboratorium, obejmując żelaznym uściskiem hydraulicznych ramion. Studentce udało się uciec dopiero wtedy, gdy dwóch wezwanych na ratunek członków personelu wyłączyło robota. Po tym incydencie zmartwiony dr Takahashi – główny opiekun Kenjiego – wyznał, iż entuzjazm grupy badawczej był przedwczesny. Co gorsza, od czasu incydentu z dziewczyną, za każdym razem, gdy Kenji zostaje włączony, reaguje podobnie na pierwszą napotkaną osobę. Natychmiast rzuca się do przytulania ofiary i artykułuje swoją miłość i przywiązanie przez zamontowany w sztucznej klatce piersiowej 20-watowy głośnik. Mimo to dr Takahashi nie chce wyłączyć Kenjiego. Wierzy, że nadejdzie dzień, gdy dzięki ulepszeniom mniej kompulsywny Kenji będzie gotów do spotkania z ludźmi. Nie wiadomo jednak, czy ludzie będą gotowi na spotkanie z Kenjim. Zaatakowana dziewczyna deklaruje już dziś, że ma nadzieję nigdy więcej go nie zobaczyć.

Kenji, źródło: http://uk.ign.comWszystko zaczęło się pewnego dnia, gdy w laboratorium pojawiła się młoda studentka, której zadaniem było testowanie nowych procedur i rozszerzanie oprogramowania Kenjiego. Dziewczyna regularnie spędzała z nim czas. Kiedy jednak nadszedł dzień końca jej stażu, Kenji zaprotestował w sposób dość dosadny: nie pozwolił jej opuścić laboratorium, obejmując żelaznym uściskiem hydraulicznych ramion. Studentce udało się uciec dopiero wtedy, gdy dwóch wezwanych na ratunek członków personelu wyłączyło robota. Po tym incydencie zmartwiony dr Takahashi – główny opiekun Kenjiego – wyznał, iż entuzjazm grupy badawczej był przedwczesny. Co gorsza, od czasu incydentu z dziewczyną, za każdym razem, gdy Kenji zostaje włączony, reaguje podobnie na pierwszą napotkaną osobę. Natychmiast rzuca się do przytulania ofiary i artykułuje swoją miłość i przywiązanie przez zamontowany w sztucznej klatce piersiowej 20-watowy głośnik. Mimo to dr Takahashi nie chce wyłączyć Kenjiego. Wierzy, że nadejdzie dzień, gdy dzięki ulepszeniom mniej kompulsywny Kenji będzie gotów do spotkania z ludźmi. Nie wiadomo jednak, czy ludzie będą gotowi na spotkanie z Kenjim. Zaatakowana dziewczyna deklaruje już dziś, że ma nadzieję nigdy więcej go nie zobaczyć.

Zimy AI, czyli „wódka jest dobra, ale mięso zepsute”

Jak widać, niezrażeni badacze sztucznej inteligencji (Artificial Intelligence – w skrócie: AI) w kontakcie z mediami często nie wykazują wstrzemięźliwości w rozbudzaniu nadziei społeczeństwa na robotyczną rewolucję. Wręcz przeciwnie – ogłaszają, że każdy nowy cyborg będzie zmieniać świat. Intrygujące, jeśli wziąć pod uwagę, że jesteśmy po ponad pięćdziesięciu latach eksperymentów. Sytuacja z superrobotem-inwalidą Aiko i hiperemocjonalnym Kenjim jest charakterystyczna dla całej dziedziny AI. Sporo tu nieudanych eksperymentów, nietrafionych inwestycji i sukcesów okraszonych frazą „tak, ale…”.

Niewiele jest pól badawczych, które w tak krótkim czasie doświadczyłyby tak licznych erupcji entuzjazmu przeplatanych falami krytyki, skutkującej zasadniczymi cięciami finansowymi. Dlatego w historii sztucznej inteligencji dobrze znane jest pojęcie „zimy”, czyli okresu obniżonego finansowania badań. Termin został ukuty przez analogię do idei zimy nuklearnej. Po raz pierwszy pojawił się w 1984 roku jako temat debaty publicznej na walnym zgromadzeniu AAAI – American Association of Artificial Intelligence. Stanowił zwięzły opis stanu emocjonalnego społeczności badawczej skupionej wokół AI: załamania wiary w przyszłość dziedziny i coraz trudniej skrywanego pesymizmu, który następnie podzieliły media.

Pierwszym potknięciem był brak sukcesów w zakresie tłumaczenia maszynowego. W latach 60., podczas zimnej wojny, rząd USA zainteresował się automatycznym tłumaczeniem rosyjskich dokumentów i raportów naukowych. W roku 1954 uruchomił program wsparcia na rzecz zbudowania maszyn do tłumaczenia. Na początku naukowcy byli optymistyczni. Przełomowe prace Noama Chomsky’ego nad gramatyką generatywną zostały zaprzężone do usprawnienia procesu. Jednak naukowców przerósł problem wieloznaczności i kontekstualności języka. Pozbawiona kontekstu maszyna popełniała śmieszne błędy. Anegdotycznym przykładem było tłumaczone najpierw z rosyjskiego, a następnie z powrotem na rosyjski z angielskiego zdanie: „duch wprawdzie ochoczy, ale ciało słabe”. Tłumaczone przez maszynę, brzmiało: „wódka jest dobra, ale mięso zepsute”. Podobnie, „co z oczu, to z serca” stało się „ślepym idiotą”.

W 1964 roku amerykańska National Research Council (NRC), zaniepokojona brakiem postępów w AI, utworzyła Komitet Doradczy ws. Automatycznego Przetwarzania Języka (ALPAC), by bliżej przyjrzeć się problemowi tłumaczenia. Komitet, w raporcie z 1966 roku, doszedł do wniosku, że automatyczne tłumaczenie jest nie tylko droższe, ale przede wszystkim mniej dokładne i wolniejsze niż praca człowieka. Zapoznawszy się z wnioskami Komitetu, po wydaniu około 20 milionów dolarów, NRC odmówiła dalszego wsparcia. To był dopiero początek problemów.

Dwie główne zimy AI odnotowano w latach 1974-80 oraz 1987-93. Złożyło się na nie kilka zdarzeń, tyleż wyczekiwanych, co rozczarowujących.

W latach 60. Defense Advance Research Projects Agency (DARPA) przeznaczyła na AI miliony dolarów. Ówczesny szef DARPA, JRC Licklider, wierzył głęboko, że należy inwestować w ludzi, a nie w konkretne projekty i w związku z tym hojnie obdzielił publicznymi pieniędzmi przywódców AI – Marvina Minsky’ego, Johna McCarthy’ego, Herberta A. Simona i Allena Newella. Był to czas, gdy ufność w rozwój sztucznej inteligencji i jej potencjał dla wojska były niezachwiane. Sztuczna inteligencja dyktowała warunki – nie tylko na poziomie ekonomicznym, ale także ideowym. Cybernetyka stała się nowym paradygmatem metafizycznym. Głosiła nowinę, że niedługo nadejdzie maszyna idealna, która intelektualnie prześcignie człowieka, ale będzie mu służyć i go chronić. Jednak po niemal dekadzie wydatków bez ograniczeń, które nie przyniosły żadnych przełomów, rząd się zniecierpliwił. Senat przegłosował poprawkę, która wymagała od DARPA finansowania bezpośredniego konkretnych badań naukowych. Badacze musieli wykazać, że ich praca rychło przyniesie frukta dla wojska. Tak się jednak nie stało. Raport grupy studyjnej, która miała przyjrzeć się działaniom DARPA, był miażdżący.

DARPA była poza tym głęboko rozczarowana wynikami naukowców pracujących nad rozumieniem mowy w ramach programu badawczego Carnegie Mellon University. Liczyła bowiem na system, który potrafiłby reagować na komendy głosowe pilota. Zespół badawczy rozwinął wprawdzie system, który mógł rozpoznać język angielski, ale tylko wtedy, gdy słowa były wypowiedziane w określonej kolejności. DARPA uważała, że została oszukana, a w 1974 roku odwołała trzy miliony dolarów dotacji. Cięcia na badania finansowane przez rząd dotknęły wszystkie ośrodki akademickie w USA. Dopiero wiele lat później sukcesy komercyjne narzędzi rozpoznawania mowy, dla których podstawę stanowiła technologia opracowana przez zespół Carnegie Mellon (np. ukryte modele Markowa) zaczęły święcić ogromne sukcesy, a rynek rozpoznawania mowy osiągnął w 2001 roku wartość 4 miliardów dolarów.

Raport Lighthilla vs. piąta generacja

Nie lepiej działo się w Wielkiej Brytanii. Spadek finansowania AI był odpowiedzią na tak zwany raport Lighthilla z 1973 roku. Profesor Sir James Lighthill został zaproszony przez parlament do oceny rozwoju AI w Wielkiej Brytanii. Według profesora AI nie zdziała niczego, czego już nie zdziałałyby lub nie mogłyby w przyszłości zdziałać inne dziedziny wiedzy. Poważnym problemem była też swoista krnąbrność zagadnień AI: Lighthill zauważył bowiem (całkiem zresztą słusznie), że wiele spektakularnych teoretycznie algorytmów AI obraca się wniwecz w konfrontacji z rzeczywistością. Problemy zderzenia maszyny z realnym światem wydawały się nierozwiązywalne. Część z nich czeka na rozwiązanie do dzisiaj. Raport doprowadził do prawie całkowitego demontażu badań AI w Anglii.

fot. Erik Charlton / Flickr CCDo odrodzenia zainteresowania sztuczną inteligencją doszło dopiero w 1983 roku, kiedy uruchomiono Alvey – projekt badawczy rządu brytyjskiego wart 350 milionów funtów. Dwa lata wcześniej Japońskie Ministerstwo Handlu Zagranicznego i Przemysłu przeznaczyło 850 milionów dolarów na tak zwane komputery piątej generacji. Celem było pisanie programów i budowanie maszyn, które mogłyby prowadzić rozmowy, tłumaczyć na języki obce, interpretować zdjęcia i obrazy, słowem: osiągnąć niemal ludzki poziom rozumności. Alvey stanowił odpowiedź na ten projekt. Niestety, do 1991 roku większość z listy zadań wpisanych na listę priorytetów Alvey nie została spełniona. Duża część nadal czeka, a jest rok 2013. Tak jak w przypadku innych projektów AI, poziom oczekiwań znacznie przewyższał to, co było możliwe do zrealizowania.

fot. Erik Charlton / Flickr CCDo odrodzenia zainteresowania sztuczną inteligencją doszło dopiero w 1983 roku, kiedy uruchomiono Alvey – projekt badawczy rządu brytyjskiego wart 350 milionów funtów. Dwa lata wcześniej Japońskie Ministerstwo Handlu Zagranicznego i Przemysłu przeznaczyło 850 milionów dolarów na tak zwane komputery piątej generacji. Celem było pisanie programów i budowanie maszyn, które mogłyby prowadzić rozmowy, tłumaczyć na języki obce, interpretować zdjęcia i obrazy, słowem: osiągnąć niemal ludzki poziom rozumności. Alvey stanowił odpowiedź na ten projekt. Niestety, do 1991 roku większość z listy zadań wpisanych na listę priorytetów Alvey nie została spełniona. Duża część nadal czeka, a jest rok 2013. Tak jak w przypadku innych projektów AI, poziom oczekiwań znacznie przewyższał to, co było możliwe do zrealizowania.

Wróćmy do roku 1983. Wtedy zareagowała także DARPA. Ponownie zaczęła finansować badania nad sztuczną inteligencją. Długoterminowym celem miała być tak zwana silna sztuczna inteligencja (strong AI), czyli – według Johna Searle’a który ukuł ten termin – dorównanie człowiekowi. Nawiasem zauważmy, że zarówno Aiko, jak i Kenji (oboje z Japonii) są próbami realizacji takiego właśnie konceptu. W roku 1985 rząd USA wydał sto milionów dolarów na 92 projekty prowadzone w sześćdziesięciu instytucjach – część w przemyśle, a część na uniwersytetach i w laboratoriach rządowych. Jednak Roger Schank i Marvin Minsky, dwaj czołowi badacze AI, którzy ciężko przeżyli pierwszy spadek finansowania z 1970 roku, ostrzegali rząd i biznes przed nadmiernym entuzjazmem. Uważali, że ambicje AI wymknęły się spod kontroli i rozczarowanie siłą rzeczy musi nastąpić. Hans Moravec, badacz i entuzjasta sztucznej inteligencji, za kryzys obwinia nierealistyczne prognozy swoich kolegów po fachu, którzy na życzenie DARPA snuli opowieści o świetlanej przyszłości. Zaledwie trzy lata później miliardowy przemysł AI zaczął podupadać.

Kilka projektów przetrwało cięcia finansowe. Znalazł się wśród nich między innymi iDART – system zarządzania walką. Okazał się niezwykle udany, oszczędził miliardy dolarów podczas pierwszej wojny w Zatoce Perskiej. Zwrócił koszta wielu innych, mniej udanych inwestycji DARPA, ukoił żale i uzasadnił pragmatyczną politykę agencji. Takich przykładów było jednak niewiele.

Wielki zawód maszyn lispowych

Historia Lispa także jest znamienna dla AI, choć ma dość przewrotny finał. Lisp to rodzina języków programowania kluczowa dla rozwoju sztucznej inteligencji. Jest tak zwanym językiem wyższego rzędu, czyli zdolnym do abstrakcji, a dzięki temu do wykorzystania elementów języka naturalnego, którym posługują się ludzie. Lisp bardzo szybko stał się ulubionym językiem programowania dla sztucznej inteligencji. Został na przykład użyty w implementacji języka programowania, który był podstawą SHRDLU – przełomowego, zaprojektowanego przez Terry’ego Winograda programu komputerowego, rozumiejącego mowę człowieka.

Gdy w latach 70. rozwinęły się badania nad AI, wydajność istniejących systemów języka Lispu stała się problemem. Lisp, jako język dość wyrafinowany, okazał się trudny do implementacji na dostępnym wtedy sprzęcie. Doprowadziło to do konieczności stworzenia tak zwanych maszyn lispowych – komputerów zoptymalizowanych do przetwarzania Lispa. Dziś takie działanie – tworzenie maszyn do obsługi pojedynczego języka – byłoby nie do pomyślenia. Wtedy jednak było zupełnie oczywiste. Żeby nadążyć, zarówno sam Lisp, jak i inne firmy, takie jak Lucid czy Franz, oferowały coraz bardziej rozbudowane wersje maszyn. Jednak postęp w dziedzinie sprzętu komputerowego i w sferze kompilatorów wkrótce sprawił, że maszyny lispowe stały się przestarzałe. A stacje robocze od firm takich jak Sun Microsystems oferowały potężną alternatywę. Także Apple i IBM zaczęły budować komputery stacjonarne, które były prostsze w obsłudze. W przełomowym roku 1987 roku stały się one bardziej skuteczne niż droższe maszyny lispowe. Cały przemysł wart pół miliarda dolarów został zmieciony z powierzchni ziemi i czułej pamięci użytkowników w ciągu jednego roku. Zgodnie z ostrzeżeniami Minsky’ego i Shanka Lisp upadł.

Postanowił jednak zmartwychwstać. W latach 80. i 90. konstruktorzy Lispa włożyli duży wysiłek w zunifikowanie wielu dialektów Lisp w pojedynczy język. Tak zwany Common Lisp był istotnie kompatybilnym podzbiorem dialektów. Choć jego budowaną z mozołem pozycję nadwyrężyło upowszechnienie się innego popularnego języka programowania – C++ i silny marketing Javy. Mimo to, Lisp doświadcza wzrostu zainteresowania od roku 2000. Paradoksalnie, rozbudzoną popularność zawdzięcza bardzo staremu medium – książce. Podręcznik „Practical Common Lisp” autorstwa Petera Seibela opublikowany w 2004 był drugą co do popularności pozycją o programowaniu na Amazonie.

Zarówno Seibel, jak kilku innych autorów (np. znany biznesmen i programista Peter Norvig), było zaintrygowanych ideą spopularyzowania języka uznawanego za przestarzały. Było to dla nich zadanie na miarę wprowadzenia do codziennego obiegu hebrajskiego dla pionierów w Izraelu. Okazało się, że przestarzały język ma swoje plusy – daje programistom nowe spojrzenie na programowanie, spawia, że są dużo bardziej wydajni. Sztuczna inteligencja kroczy dziwnymi ścieżkami.

Strach przed kolejną zimą

W późnych latach 90. i na początku XXI wieku technologie AI stały się wprawdzie powszechne, ale ich sukcesy często były marginalizowane, głównie dlatego, że ich obecność przestała być dostrzegalna. Nick Bostrom zauważył nawet, że inteligentne przedmioty codziennego użytku stają się tak oczywiste, że zapomina się, iż są inteligentne. Przychyla się do tego Rodney Brooks – innowacyjny, niezwykle utalentowany badacz i programista, który podkreśla, że mimo powszechnego poglądu o upadku sztucznej inteligencji, otacza nas ona na każdym kroku.

Technologie opracowane przez badaczy sztucznej inteligencji osiągnęły komercyjny sukces w wielu dziedzinach, jak chociażby skazywane początkowo na klęskę tłumaczenie maszynowe, wyszukiwanie danych, robotyka przemysłowa, logistyka, rozpoznawanie mowy czy diagnostyka medyczna. Logika rozmyta (czyli taka, w której między stanem 0 a 1 rozciąga się szereg wartości pośrednich) została zaprzężona do zbudowania automatycznych skrzyń biegów w samochodach Audi TT, VW Touareg, Škoda.

źródło: spiderlily-studio.webs.com

źródło: spiderlily-studio.webs.com

Lęk przed kolejną zimą stopniowo ustępował. Niektórzy badacze nadal wyrażali obawy, że nowa zima AI może nadejść z kolejnym zbyt ambitnym projektem lub nierealną obietnicą daną publicznie przez wybitnych naukowców. Były na przykład obawy, że robot Cog zrujnuje ledwo podreperowaną reputację AI. Ale tak się nie stało. Cog był projektem realizowanym na Humanoid Robotics Group z MIT przez wzmiankowanego już Rodneya Brooksa, wspólnie z multidysplinarną grupą badaczy, w której znalazł się także znany filozof Daniel Dennett. Projekt Cog opierał się na założeniu, że poziom inteligencji człowieka wymaga doświadczenia nabieranego dzięki kontaktowi z ludźmi. Toteż Cog miał za zadanie w takie interakcje wchodzić i uczyć się tak, jak uczą się niemowlęta. Celem realizatorów projektu Cog było między innymi zaprojektowanie i stworzenie humanoidalnej twarzy, która pomagać będzie robotowi w nawiązywaniu i podtrzymywaniu kontaktów społecznych z ludźmi, stworzenie robota, który zdolny byłby do oddziaływania na ludzi i przedmioty tak jak człowiek, budowa systemu odczuwania siebie – mechanicznej propriocepcji (czyli zmysłu orientacji ułożenia części własnego ciała), rozwój skomplikowanych systemów wzroku, słuchu, dotyku, a także wokalizacji, i wreszcie systemu kontroli efektywności energetycznej podczas wykonywania ruchów. Z samej listy zadań łatwo wywnioskować, jak ambitnym projektem był Cog. W związku z (surprise, surprise!) brakiem oczekiwanych rezultatów, Cogowi ucięto finansowanie w 2003 roku. Okazało się jednak, że tym razem nie do końca udany projekt przysłużył się dziedzinie. Wzmianki o nim rozbudziły bowiem zbiorową wyobraźnię, która czekała na coś tak przypominającego człowieka, nawet jeśli to coś było ułomne. Podobnie stało się zresztą z Deep Blue, który mimo kilku porażek i tak był znakomitym mistrzem szachowym – mierzył się z ludźmi, wchodził z nimi w interakcje – i to się liczyło.

Czekając na wiosnę

Szczyt zawyżonych oczekiwań zderza się z głębokim dołem rozczarowania, a później następuje – centralne dla rozwoju technologii – „odwrócenie uwagi”, kiedy może ona spokojnie „dojrzewać”, by potem przyspieszyć. Rzecz jasna, do tej pory nigdy nie przyspieszyła na tyle, by nas zadowolić.

Przyglądając się huśtawce nastrojów, na której od około siedmiu dekad buja się sztuczna inteligencja, zmieniłam pogląd na to, czym docelowo ma być inteligenta maszyna. Długo uważałam, że humanoidalny robot ma być zwierciadłem człowieka. Dzisiaj zadaję sobie pytanie, dlaczego chcemy by robot był bardziej idealny od człowieka. Dlaczego nie pozwalamy mu upadać? Dlaczego, kiedy upada, uparcie próbujemy dalej? Przecież nie w tym rzecz, że za kilka lat technologia pozwoli rozwikłać wszystkie zagadki człowieczeństwa i zbudować sztucznego człowieka. To stanie się nieprędko. Jest jakiś inny czynnik, który pcha człowieka do tej absurdalnej skądinąd dziedziny. Wszak, jeśli się dobrze zastanowić, sama jej nazwa – sztuczna inteligencja – jest dość groteskowa. Naprowadza na pewien trop: maszyna niezupełnie jest zwierciadłem, jest raczej czymś, co ma pozostać inne, ale ma nas przerosnąć. Dzięki inności maszyny będziemy się czuć bezpiecznie, bo dla nas – ludzi – podobieństwo jest niepokojące. Potwierdzają to popkulturowe wizje maszyny przejmującej kontrolę nad światem, którymi karmimy się od ponad wieku. Dzięki temu, że maszyna (będąc inną) staje się lepsza od nas w rzeczach, w których chcemy być wyręczeni, możemy zachowywać się wobec niej jak nieco patologiczni rodzice. Oczekiwać, stawiać wyzwania, obrażać się, przepraszać, by potem wrócić z nową porcją energii i oczekiwań.

Nic nie szkodzi, że Aiko i Kenji ciągle gubią się w ludzkim świecie. Są inni, są dziwaczni, ale i tak piękna z nich para. Poza tym robią to, co potrafią najlepiej. On się przytula, a ona wymierza policzki.