MONIKA PASIECZNIK: Internet wyzwolił w użytkownikach energię do uczenia innych, do przekazywania własnych umiejętności. Niektórzy próbują jednak ten przepływ wiedzy blokować. O tym opowiada opera „Aaron S.”?

KRZYSZTOF CYBULSKI: Postać Aarona Swartza, do którego odnosi się tytuł opery, była wielowymiarowa, w jego działalności oczywiście istotny był aspekt społeczny i polityczny, postrzeganie wiedzy jako dobra wspólnego, do którego wszyscy powinni mieć nieograniczony dostęp. Mnie jednak najbardziej zapadło w pamięć jego stwierdzenie, że umiejętność programowania jest jak magia – rzeczywiście w pewnym sensie tak jest, programując, możemy tworzyć nowe byty, ograniczają nas jedynie własne umiejętności, wyobraźnia i czas, którego programowanie oczywiście sporo wymaga.

Jesteś członkiem grupy panGenerator, w której zajmujesz się dźwiękiem. Jak do niej trafiłeś?

Dwóch kolegów z panGeneratora, Piotr Barszczewski i Jakub Koźniewski, miało pomysł na projekt i szukało kogoś, kto odpowiadałby za dźwięk, bo sami uznali, że nie do końca sobie z tym radzą. Ja wówczas prowadziłem warsztaty z programu Reaktor, umożliwiającego programowanie własnych syntezatorów i efektów. Piotrek znalazł informację o tych warsztatach, przyszedł na nie i zaproponował mi współpracę. Na początku rzeczywiście odpowiadałem wyłącznie za dźwięk. Naszym pierwszym projektem był „Dodecaudion”, kontroler muzyczny, na którym grało się poprzez ruch, przybliżanie bądź oddalanie dłoni i innych części ciała do dwunastościennej bryły wyposażonej w czujniki odległości.

Dla mnie to było ciekawe, bo oprócz muzyki zawsze fascynowałem się elektroniką, mechaniką, wynalazkami. Wiedziałem, czym jest ruch DIY [ang. do it yourself, zrób to sam – przyp. red.], że istnieje coś takiego, jak Arduino, czyli mikrokontroler, który można samemu programować, ale miałem wrażenie, że jest to poza zasięgiem mojej wiedzy i umiejętności. Kuba i Piotrek byli pierwszymi poznanymi przeze mnie osobami, które się tym zajmowały. Niedługo potem Kuba wyszedł z propozycją stworzenia grupy, wtedy dołączył do nas Krzysztof Goliński.

Na początku każdy z nas miał kompetencje dość specjalistyczne, w związku z czym do stworzenia bardziej złożonych projektów potrzebna była współpraca całej czwórki. Ponieważ jednak praca przy każdym kolejnym przedsięwzięciu wymagała od nas ciągłego pogłębiania wiedzy i umiejętności, poznawania nowych narzędzi i komponentów, w ciągu sześciu lat istnienia panGeneratora kompetencje każdego z nas mocno się rozszerzyły. Dużo dowiedziałem się od chłopaków o programowaniu, o wykorzystywaniu układów elektronicznych typu Arduino, a także o sterowaniu za ich pomocą silnikami, serwomechanizmami itp. Ale też nauczyłem się sporo o tzw. sztuce nowych mediów i stojącej za nią technologii. Kluczowa jest tu umiejętność samodzielnego uczenia się przy pomocy ogromnej ilości materiałów dostępnych w internecie. Każde urządzenie, każdy język programowania posiada dokumentację techniczną oraz sporą ilość tutoriali internetowych i przykładów gotowych prac, z których można się uczyć lub wręcz skopiować fragmenty kodu albo dowiedzieć się, jak to zrobić samemu.

Niektóre swoje pomysły realizujesz poza panGeneratorem.

PanGenerator ma, szczególnie na obecnym etapie, dość jasno określony profil: chcemy dotrzeć do szerokiego grona osób. Nasze projekty nie wymagają od odbiorców żadnego przygotowania, ludzie mogą czerpać przyjemność z czystej interakcji. Ta interakcja jest intuicyjna, bazuje na ruchu, przejrzystych i prostych interfejsach, np. w postaci pojedynczego pokrętła lub przycisku. Tymczasem moje pomysły na dźwiękowe obiekty interaktywne opierają się na dość niszowych zagadnieniach, takich jak akustyka czy generowanie dźwięku, i są adresowane raczej do ludzi, którzy zajmują się muzyką lub przynajmniej są świadomi rządzących nią reguł. Wiele z tych projektów to nowe instrumenty muzyczne, które prawdopodobnie nie przeszłyby sita w panGeneratorze jako rzeczy zbyt hermetyczne i niekoniecznie intuicyjne. Robię je więc na boku działalności w grupie. Każdy z chłopaków z panGeneratora robi też swoje rzeczy. Myślę, że taki układ jest w porządku. To, co tworzymy razem, jest wypadkową pracy zespołowej i naszej wspólnej wizji tego, czym ma być panGenerator, natomiast odbiegające od tej wizji własne fascynacje możemy realizować na zewnątrz.

Jak zacząłeś budować swoje instrumenty muzyczne?

Przez wiele lat próbowałem stworzyć zespół muzyczny, co niestety okazało się dość trudne, skłonienie profesjonalnych muzyków do grania wymaga konkretnych argumentów w postaci np. zabukowanych terminów koncertów, nie mówiąc o tym, że moje pomysły na muzykę zawsze były dość niestandardowe, co nie ułatwiało sprawy. Wtedy pomyślałem, że być może łatwiejszym sposobem uprawiania muzyki, o jakiej marzyłem, jest tworzenie wszystkich dźwięków samodzielnie. Około roku 2008 zacząłem przyglądać się scenie laptopowej i zastanawiać, jaki arsenał środków przygotować, by móc grać solo z laptopa. To był moment, gdy laptopy zaczęły być w zasięgu normalnego człowieka, można było nabyć takie urządzenie za trzy pensje. Jednak szybko rozczarowałem się sceną laptopową, bo okazało się, że poza kilkoma chlubnymi wyjątkami wielu muzyków produkuje utwory w domu, a potem na scenie odgrywa gotowe aranże – nawet jeżeli są one generowanie w czasie rzeczywistym w sensie wirtualnych generatorów, tak naprawdę wykonywanie ich na żywo ogranicza się do kontroli kilku parametrów, jakichś filtrów czy efektów przy pomocy gałek itp. Ja tymczasem chciałem grać w 100 procentach na żywo, improwizować, tak jak robiłem to już, grając na gitarze basowej. Zacząłem konstruować w tym celu drobne aplikacje, korzystając ze wspomnianego Reaktora. To była kamienista droga, pierwsze występy wspominam jako chaos, nad którym ledwo panowałem, ale w końcu znalazłem sposób. Wtedy dotarło do mnie, że współpraca z muzykami jest fantastyczna, a interakcja nie do przecenienia, natomiast grając w pojedynkę, ja sam decyduję, co się tak naprawdę dzieje, również w tym sensie, że nie występują problemy logistyczne i interpersonalne. Nie porzucam jednak ostatecznie myśli o realizowaniu swoich pomysłów z pomocą innych muzyków.

Powiedziałeś, że konstruujesz instrumenty. Czujesz się bardziej budowniczym instrumentów niż artystą dźwiękowym?

W operze „Aaron S.” jestem „panem inżynierem”, który dostarcza narzędzia dla „pana kompozytora”. W głębi budzi się jednak potrzeba powiedzenia czegoś własnego poprzez narzędzia, które stworzyłem. Myślę, że znajduję się gdzieś pomiędzy: jestem muzykiem – wykonawcą, gram na gitarze basowej, studiowałem jazz, trochę komponuję, ale też zawsze ciągnęło mnie do konstruowania instrumentów. Przez rok uczęszczałem na zajęcia z lutnictwa w Liceum Plastycznym w Zakopanem, po czym kontynuowałem naukę już na kierunku rzeźby, później studiowałem kompozycję jazzową. Uderza mnie różnica pomiędzy kryteriami oceny sztuki i rzemiosła, gdyż w taki uproszczony sposób można chyba zaklasyfikować te dwa rodzaje twórczości. W przypadku pracy nad instrumentami, urządzeniami czy oprogramowaniem można zastosować proste kryterium jakości: działa – nie działa. W przypadku pracy nad kompozycją często dobija mnie stan niepewności, czy to już jest skończone, czy jeszcze nie, czy jest to oryginalne, czy też wtórne, naiwne. Być może zatem z asekuracji przyjąłem rolę „pana inżyniera”, rzemieślnika, chciałbym jednak w najbliższej przyszłości z niej wyjść.

Punktem wyjścia było tworzenie instrumentów, które umożliwiłyby mi pełną realizację moich pomysłów podczas improwizacji. Z fortepianem, który daje chyba największe możliwości do rozwijania całej struktury utworu, było mi zawsze nie po drodze. Jako basista musiałem z kolei kombinować, jak uzyskać coś więcej niż tylko pojedyncze niskie dźwięki. Dlatego szukałem wsparcia cyfrowego. Instrumenty, które tworzę, mają ukryty cel – móc wydobyć w czasie rzeczywistym więcej dźwięków niż jedna osoba, która ma tylko dwie ręce.

Twierdzisz, że najchętniej pracujesz w drewnie i aluminium. To może być zaskakujące dla kogoś, kto kojarzy cię z twórczością panGeneratora.

W pracach z panGeneratorem również wykorzystujemy drewno i aluminium. Tyle że tam, kiedy już ustalimy podstawowe zasady działania nowej instalacji, powstaje bardzo precyzyjny projekt wizualny, którego potem staramy się trzymać. Aspekt estetyczny w działalności panGeneratora jest niezwykle ważny.

W moich własnych działaniach jest inaczej: najczęściej wychodzę od pomysłu na działanie nowego urządzenia i nie mając jeszcze żadnej konkretnej koncepcji jego formy, już zaczynam coś robić, wycinam kawałek sklejki, sprawdzam, czy to działa, tworzę prototyp funkcjonalny. W jakimś sensie forma jest u mnie wtórna wobec funkcji.

Opowiedz więcej o tym, jak pracujesz.

Na początku wymyślam jakąś zasadę działania urządzenia na poziomie mechaniczno-akustycznym. Przez lata tworzyłem narzędzia cyfrowe w głębi komputera, lecz w którymś momencie zdałem sobie sprawę, że wszystko to brzmi podobnie, głośnik nieprawdopodobnie spłaszcza dźwięki. Kiedy idziemy ulicą i słyszymy dźwięk pianina, jest dla nas jasne, że ono stoi w pokoju, ktoś na nim gra i nie jest to nagranie z głośnika, choćby najwyższej jakości. Myślę, że ta różnica nie wynika z rozkładu częstotliwości czy dynamiki, lecz z przestrzenności dźwięku. Pianino z każdej strony brzmi inaczej. Tak jest z każdym instrumentem: puzon niby jest ze swej natury monofonicznym źródłem dźwięku, generuje dźwięk z jednego miejsca, ale kiedy nie stoimy na bezpośredniej linii tego dźwięku, tylko na przykład chodzimy dookoła instrumentu, słyszymy, jak jego dźwięk płynnie się zmienia, np. z boku słyszymy bardziej wibrację metalu itp.

Prawykonanie opery „Aaron S.” na Warszawskiej Jesieni

Kolektyw Aaron S:

Sławomir Wojciechowski – kompozycja,

Paweł Krzaczkowski – libretto,

Krzysztof Cybulski – konstrukcja instrumentów, software,

Norman Leto – wideo.

LUX:NM Contemporary Music Ensemble Berlin: Małgorzata Walentynowicz – fortepian (kontroler MIDI), Ruth Velten – saksofon, Silke Lange – akordeon, Wolfgang Zamastil – wiolonczela, Florian Juncker – puzon

21 września, godz. 19:30, Teatr Imka.

Szczegółowy program na stronie internetowej Warszawskiej Jesieni.

Dlatego obecnie interesuje mnie tworzenie akustycznych źródeł dźwięku. Technologia cyfrowa, która jest dzisiaj tania i dostępna, umożliwia natomiast precyzyjną kontrolę zjawisk akustycznych przez różne mechanizmy sterowane z komputera. Jeszcze pięćdziesiąt lat temu nie istniały takie urządzenia, jak precyzyjne silniki krokowe czy serwomechanizmy. Do niedawna niektóre zjawiska akustyczne były kompletnie nieokiełznane. Weźmy choćby sprzężenie audio, które wielu muzyków próbowało wykorzystać do celów muzycznych – sławni gitarzyści rockowi robili sprzężenie, przykładając gitarę do głośnika. To zawsze było trochę poza kontrolą, w zależności od wilgotności powietrza i innych czynników nie było wiadomo, jaki dźwięk się wydobędzie. Chcąc spojrzeć na to zjawisko ze współczesnej perspektywy, zbudowałem urządzenie, które nazywa się „Feedback Synth”, składające się z mikrofonu i głośnika na ruchomej głowicy sterowanej w dwóch płaszczyznach przez serwomechanizmy, które umożliwiają precyzyjne ustawienie ich wzajemnej pozycji. Każda pozycja generuje inny dźwięk, który możemy odtworzyć, przywołując po raz kolejny daną pozycję głośnika i mikrofonu. Napisałem w Pure Data niewielki program umożliwiający sterowanie tymi ustawieniami za pomocą komputera z podłączoną klawiaturą midi. Dzięki elektronice i technologii cyfrowej mogę precyzyjnie kontrolować takie zjawisko, jak sprzężenie audio. Mogę wręcz zagrać melodię na sprzężeniu. To było olśnienie, że znane od dawna zjawiska akustyczne można dziś okiełznać za pomocą technologii i rozwijać ich możliwości muzyczne. To jest dla mnie jakimś rodzajem obsesji.

Innym ciekawym zjawiskiem akustycznym, którym się zajmujesz, są tzw. tony kombinacyjne, opisane po raz pierwszy przez Giuseppe Tartiniego w „Trattato di musica” z 1754 roku.

Tonami kombinacyjnymi zajmowałem się w dwóch kompozycjach: „AAABBBEEIKKR” i „MORPH”. Jeśli dwa dźwięki są do siebie zbliżone częstotliwością, powstaje trzecia, znacznie niższa częstotliwość. Tony kombinacyjne pozwalają nam słyszeć dźwięki, których tak naprawdę nie ma – na przykład głośniki laptopowe nie są w stanie odtworzyć dźwięków basowych, słyszymy je tylko dlatego, że składowe harmoniczne niskich dźwięków dają wspólny, niski ton kombinacyjny. O ile mi wiadomo, nie ma konsensusu naukowego, czy jest to zjawisko fizyczne, czy powstaje wyłącznie na poziomie percepcji, w naszym mózgu. Do zajęcia się tonami kombinacyjnymi zainspirował mnie Clarence Barlow, który stworzył cykl utworów „Until”. Mamy tu generator sinusoidy grający jedną nutę i na przykład flet piccolo grający wokół tej nuty różne dźwięki. Słyszymy trzy dźwięki, z czego ten trzeci jest wypadkową dwóch faktycznie rozbrzmiewających dźwięków. Partia fletu jest oczywiście napisana tak, aby ten trzeci dźwięk – ton kombinacyjny – miał określoną wysokość.

Mój pomysł polegał na tym, by napisać program imitujący proces powstawania tonów kombinacyjnych: na podstawie dwóch dźwięków w czasie rzeczywistym generowany jest dźwięk trzeci, którego wysokość jest wypadkową wysokości dźwięków wyjściowych, a jego barwa jest wypadkową brzmień użytych instrumentów – wiolonczeli i klarnetu basowego. Pracując nad utworem „MORPH” (którego nazwa pochodzi właśnie od morfowania dwóch dźwięków tak, by powstał trzeci), improwizowałem na dwóch klawiaturach, z których każda odpowiadała za jeden instrument, i słuchałem, jak kształtuje się trzecia linia melodyczna, generowana przez Pure Data. Potem zarejestrowane improwizacje poddałem edycji, tworząc z co ciekawszych współbrzmień docelową kompozycję. Oprogramowanie było zatem kluczowe dla całej struktury kompozycji. Było ono również wykorzystywane podczas wykonań utworu, każdorazowo tworząc trzecią linię melodyczną na żywo, reagując na wszelkie niuanse gry instrumentalistów. To pokazuje również, jak widzę rolę live electronics w muzyce: jako integralny element kompozycji zarówno na poziomie brzmienia, jak i struktury. Kompozycja „MORPH” nie mogłaby powstać ani zostać odtworzona bez komputera.

Dodatkowym zabiegiem było ustawienie komputera na scenie pomiędzy dwoma muzykami. Komputer był zwrócony ekranem do publiczności, w odróżnieniu od częstej praktyki umieszczania komputerów poza sceną, przy mikserze reżysera dźwięku. Komputer stał na głośniku wzmacniającym generowane przezeń dźwięki. Był więc niejako trzecim wykonawcą. Z drugiej strony, integracja dźwięku generowanego przez komputer z dźwiękiem żywych instrumentów doprowadziła do zabawnej sytuacji – wielu ludzi po prawykonaniu mówiło, że w ogóle nie słyszało dźwięków komputera. Spodziewali się wyraźnie odcinającego się cyfrowego brzmienia, a tymczasem dźwięk był zespolony z żywymi instrumentami zarówno brzmieniowo, strukturalnie, jak i przestrzennie.

Poszukujesz wspólnego mianownika dla technologii i natury.

Fascynuje mnie spektralizm jako spełnienie idei organicznego połączenia technologii i naturalnych właściwości akustycznych instrumentów, doskonałe połączenie technologii i muzyki. Jednocześnie zdałem sobie sprawę, że technologie używane przez pierwszych spektralistów w latach 70. – jeszcze analogowe lub pierwsze cyfrowe analizatory widma – dzisiaj stały się ogólnodostępne pod postacią darmowych programów, które można uruchomić na każdym komputerze osobistym, nawet takim za 800 zł. Każdy może analizować w czasie rzeczywistym spektrum harmoniczne dowolnego dźwięku. Wpadłem więc na pomysł, by napisać program, który nie tylko analizuje składowe harmoniczne dźwięku, ale przepisuje je na konkretne wysokości nut, określając ich głośność i inne parametry, i od razu generuje zapis nutowy. Część graficzną programu napisałem praktycznie od zera, ze wsparciem kolegów z panGeneratora. Zasada działania jest taka: dźwięk zbierany mikrofonem jest przetwarzany na konkretne wysokości składowych harmonicznych rozpisane na kilku systemach pięcioliniowych. Mamy więc na przykład siedmioosobowy zespół, każdy z muzyków ma kilka minut na zaimprowizowanie np. krótkiej melodii, której składowe harmoniczne w ułamku sekundy są wyświetlane na ekranie. Zapis muzyczny przesuwa się i kiedy przechodzi przez kursor na środku ekranu, muzycy grają go a vista. Powstaje rodzaj kanonu czy harmonicznego echa do tego, co zostało zaimprowizowane przez danego muzyka. Projekt nazywa się „Spectral Score” i brali w nim udział muzycy klasyczni, jazzowi, popowi; jedynym kryterium była umiejętność improwizowania i czytania a vista. Oczywiście efekt jest odległy od spektralizmu jako stylu, nie ma mikrotonów, ale przestałem się przy nich upierać, bo bardziej interesowało mnie to, że mamy komputer jako integralny element zjawiska muzycznego, a jednocześnie utwór jest akustyczny, komputer nie generuje żadnego brzmienia, lecz strukturę, która jest grana przez instrumenty akustyczne. Taka forma interakcji między muzykami nie jest możliwa bez komputera.

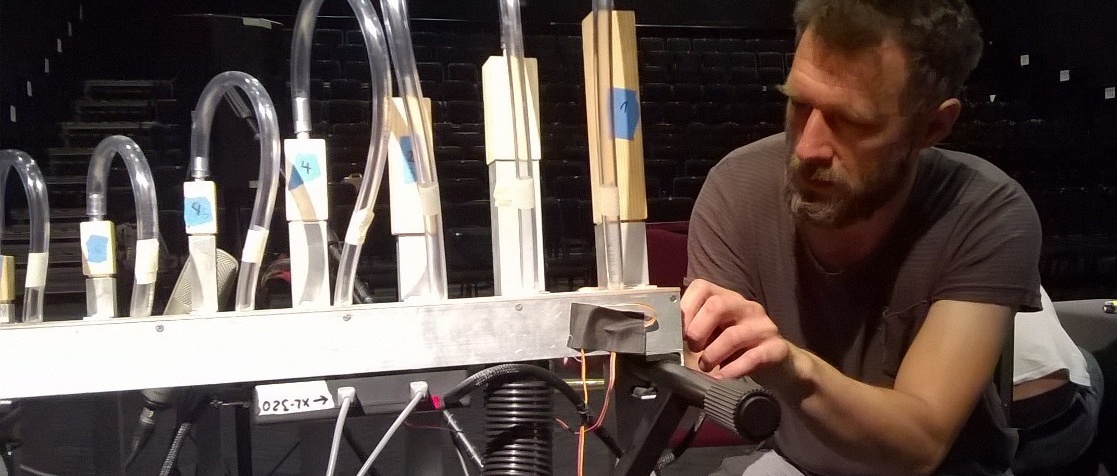

Ostatnio pracowałem nad urządzeniem, które nazywa się „Akustyczny syntezator addytywny” i będzie wykorzystane w operze „Aaron S.”. Idę w nim o krok dalej: badam, co by się stało, gdybym wyeliminował muzyków ze „Spectral Score” i zastąpił ich zrobotyzowanymi piszczałkami? Tak powstały piszczałki grające składowe harmoniczne, np. dźwięku nagranego przez mikrofon.

Krzysztof Cybulski

Ur. w 1980, basista, kompozytor, twórca cyfrowych narzędzi muzycznych, instrumentów i instalacji interaktywnych. Absolwent Akademii Muzycznej im. Karola Szymanowskiego w Katowicach w zakresie kompozycji i aranżacji jazzowej. Aktywny wykonawca i improwizator, wykorzystujący oprogramowanie i instrumenty własnej konstrukcji. Od 2010 r. współtworzy artystyczną grupę nowomediową panGenerator.

Współpracował m.in. z Krzysztofem Knittlem, Anną Zaradny, Sławomirem Wojciechowskim, Mikołajem Pałoszem, Michałem Górczyńskim. Współtwórca postrockowego zespołu Lomi Lomi, związanego z wytwórnią Lado ABC, oraz improwizującego tria Cybulski–Pałosz–Wojciechowski. Autor przedsięwzięć muzyczno-technologicznych, m.in. „Acoustic Additive Synth”, „Feedback Synth”, „Spectral Score” z udziałem instrumentalistów z różnych środowisk.

Jaki jest związek między „Akustycznym syntezatorem addytywnym” a spektralizmem?

Pierwsi spektraliści, jak choćby Horatiu Radulescu, mieli świadomość, że resynteza powinna się dokonywać za pomocą tonów prostych, czyli fal sinusoidalnych. Jednak poza kamertonem i flażoletami wykonywanymi na instrumentach strunowych praktycznie nie ma instrumentów, które generowałyby takie tony; najbliżej jest dźwięk fletu. Radulescu pisał utwory na 40 fletów poprzecznych, jednak ich wykonanie musiało nastręczać sporych problemów praktycznych; inni spektraliści nie byli już tak purystyczni i wykorzystywali orkiestry o bardziej tradycyjnym składzie. Chcąc zbliżyć się do brzmienia sinusoidy, postanowiłem jednak wykorzystać w moim instrumencie tzw. flety suwakowe, podobne do popularnych niegdyś lizaków z gwizdkiem. Fabryczne flety suwakowe produkowane są jednak tylko w jednym stroju, dlatego skierowałem swoją uwagę na piszczałki organowe, które mogą mieć dowolne rozmiary. Znalazłem znakomitego organmistrza Marcina Armańskiego, który wykonał dla mnie siedem drewnianych piszczałek. Do każdej z nich dodałem rurę aluminiową, w której znajduje się suwak pełniący funkcję podobną jak w lizakach. Przesuwanie suwaka powoduje zmianę wysokości dźwięku w zakresie oktawy lub więcej. Ruch suwaka jest sterowany przez komputer przy pomocy Arduino, a więc z komputera możemy płynnie sterować wysokościami dźwięku. Zbudowałem również skrzynkę ze zmechanizowanymi zaworami, umożliwiającą sterowanie głośnością poprzez regulację dopływu powietrza do piszczałek z dmuchawy. Mamy więc akustyczne oscylatory prawie sinusoidalne, a każda z piszczałek odgrywa rolę muzyka ze „Spectral Score”.

Premiera instalacji „Muzyka sfer” panGeneratora na Warszawskiej Jesieni 2016, fot. Grzegorz Mart

Premiera instalacji „Muzyka sfer” panGeneratora na Warszawskiej Jesieni 2016, fot. Grzegorz Mart

Swój instrument pokazałeś po raz pierwszy na zeszłorocznym festiwalu „Instalakcje” w Warszawie, prezentowałeś go również na Guthman Musical Instrument Competition. Co zmieniłeś w jego działaniu z myślą o operze „Aaron S.”?

Na „Instalakcjach” można było podejść do mikrofonu, coś zaśpiewać albo powiedzieć, na co piszczałki odpowiadały, imitując ludzki głos. To był prototyp, wersja instalacyjna instrumentu. Dla potrzeb opery zbudowałem drugą, bardziej dopracowaną i kompaktową wersję. W operze „Aaron S.” fragmenty muzyczne będą grane na piszczałkach, czasem solo, a czasem w połączeniu z zespołem instrumentalnym. W tej chwili Sławek Wojciechowski komponuje na ten instrument muzykę, sterując bezpośrednio suwakami i zaworami. Wykorzystuje możliwości, jakimi dysponują piszczałki, czyli m.in. mikrotonowe różnice wysokości dźwięku oraz glissanda, co różni je od tradycyjnych organów piszczałkowych, nawet tych najnowocześniejszych, którymi można sterować poprzez protokół midi. Ale wykorzystane będą też sample mowy, poddawane analizie i imitowane przez piszczałki – ta pierwotna funkcja instrumentu również znajdzie zastosowanie w operze. Mam nadzieję, że dźwięk piszczałek wtopi się w brzmienie tradycyjnych instrumentów wykorzystywanych w operze – piszczałki są w gruncie rzeczy również instrumentem akustycznym (choć oczywiście wszystkie instrumenty będą nagłośnione, co jest nieuniknione ze względu na rozmiary sali koncertowej).

Na potrzeby opery skonstruowałeś jeszcze dwa inne urządzenia.

„Muzyka sfer” na Małej Warszawskiej Jesieni

Instalacja grupy panGenerator składa się z kilku obiektów w formie piłek, które wydają dźwięki pod wpływem uderzania, odbijania. Każdy z obiektów zawiera odpowiednio zabezpieczone elementy elektroniczne – czujniki ruchu/pozycji (akcelerometr) oraz nadajnik bezprzewodowy, pozwalające na przesyłanie informacji o położeniu i ruchu obiektów do komputera z oprogramowaniem generującym dźwięki. Dźwięk może mieć różną formę, od prostego odwzorowania (ściskanie piłek wywołuje efekt jak przy odkręcaniu gałki filtra w syntezatorze, odbijanie wywołuje kreskówkowe sprężynujące dźwięki) do bardziej złożonych, w których odpowiednie obracanie i poruszanie piłkami pozwala na tworzenie struktur muzycznych. W tym przypadku każdy z obiektów może odpowiadać za brzmienie jednego instrumentu; odgrywana może być sekwencja, w której dźwięki instrumentów są zsynchronizowane rytmicznie, a ich wysokości i wartości rytmiczne zależą od dynamiki ruchu piłek. Dźwięk odtwarzany jest z głośników podłączonych do komputera.

Warszawa, Park Rzeźby Królikarnia, codziennie do 25.09 w godzinach 10–18

Jedno z nich to specjalny gramofon. Chcieliśmy wykorzystać naturalny głos ludzki, ale bez udziału żywych aktorów czy śpiewaków. Stąd przewrotny pomysł na odtwarzanie głosu z płyty winylowej. Początkowo chciałem wykorzystać czysto akustyczny gramofon czy, jak niektórzy wolą, patefon. Podczas pracy okazało się jednak, że stare płyty odtwarzane na tych gramofonach mają rowki innej głębokości i szerokości, co powoduje, że odsłuchanie współczesnych płyt na takich gramofonach jest praktycznie niemożliwe. Gdy po wielu modyfikacjach udało mi się w końcu odtworzyć współczesną płytę, okazało się, że dźwięk jest zdecydowanie zbyt cichy. W operze wykorzystujemy oczywiście płyty we współczesnym standardzie microgroove, wykonane specjalnie dla nas i zawierające sample głosów i muzyki Sławka. Jedynym wyjściem było wykorzystanie gramofonu elektrycznego, który ma jednak dwie znaczące modyfikacje: pierwsza to możliwość regulacji prędkości obrotu w zakresie 0–400 procent, co oznacza, że możemy transponować dany materiał dźwiękowy 3 oktawy niżej i 4 otawy wyżej. Używając suwaka prędkości, możemy grać na gramofonie jak na instrumencie, zmieniając wysokość dźwięku. Drugim nowym elementem jest mały głośnik ukryty wewnątrz gramofonu, hermetycznie obudowany małym pudełeczkiem, z którego wystaje roztrąb puzonu. Dźwięk nagrany na płycie możemy przetwarzać akustycznie również przez zastosowanie tłumików puzonowych. Mamy więc akustyczny sampler: dźwięki są nagrane fizycznie na płycie w formie rowków, potem ich wysokość może być zmieniana poprzez zmianę prędkości obrotów, a na końcu są przetwarzane akustycznie przez tłumiki.

Są jeszcze translatory.

To trzeci instrument, który rozwijam na potrzeby opery „Aaron S.”. Pomysł wyniknął z projektu Marcina Cecko, choć już wcześniej był wykorzystywany przez innych twórców. Otóż Cecko napisał wiersz „Czekam w kuchni na oświecenie”, który był tłumaczony na wiele różnych języków, z czego kolejne tłumaczenia były dokonywane nie z oryginału, lecz z już gotowego tłumaczenia, za każdym razem innego. Na koniec łańcuszka wiersz został ponownie przetłumaczony na Polski i okazało się, że to zupełnie inny wiersz.

Znów pomyślałem o tym, jak wyeliminować czynnik ludzki z tego procesu? Wykorzystałem narzędzie Google Translator. Ponieważ cała opera „Aaron S.” jest trójjęzyczna, również jeśli chodzi o zaangażowane w nią osoby – opera opowiada o amerykańskim hakerze i jest ideowo zakorzeniona w ruchu Open Source, z drugiej strony mamy zespół niemiecki, my zaś jesteśmy polskimi twórcami – w związku z tym wydawało się naturalne wykorzystanie tych trzech języków: polskiego, angielskiego i niemieckiego. Aplikacja Google Translatora rozpoznaje głos i jest wyposażona w generator mowy. Wystarczy powiedzieć parę zdań do mikrofonu i natychmiast otrzymujemy ich tłumaczenia na angielski, otwarta w kolejnym oknie wersja aplikacji słucha tłumaczenia angielskiego i przekłada je na niemiecki, trzecia tłumaczy z niemieckiego na polski. Zdanie się w tym czasie transformuje. Jest to rodzaj głuchego telefonu.

Wyciągnąłem aplikację z komputera i wstawiłem ją do trzech małych pudełeczek, z których każde jest urządzeniem tłumaczącym jedną parę języków. Zrobiłem to na najprostszych smartfonach za 200 zł, które umieszczone są w tychże pudełkach. Pudełka są wyposażone w mały głośnik i w mały mikrofon. Chodziło o to, by mieć prostą wizualną sytuację: mamy ekran, na którym wyświetla się tekst, mamy mikrofon i głośnik, więc każdy rozumie, że pudełko z jednej strony słucha, z drugiej nadaje. Pudełka ustawione są w kształt trójkąta, który przypomina znak recyklingu, co nawiązuje do recyklingu słownego i dźwiękowego, czyli samplingu. Paweł Krzaczkowski przygotował kilkanaście zdań, które są odczytywane po angielsku, potem tłumaczone na polski, z polskiego na niemiecki i z powrotem na angielski. Zdania krążą między urządzeniami. Obserwujemy, jak program pisze dane słowo, cofa je, szuka i pisze następne. Dedukuje, co zostało powiedziane. Początkowo translatory miały być obecne na scenie, kiedy jednak okazało się, że za każdym razem tłumaczą inaczej, zaś atrakcyjne translacje zdarzają się stosunkowo rzadko, zdecydowaliśmy nagrać jak najwięcej tych translacji na wideo i wybrać najlepsze fragmenty. Udało nam się uchwycić naprawdę kuriozalne tłumaczenia, które w przewrotny sposób nawiązują do tematyki opery. Same pudełeczka zamierzamy natomiast udostępnić w foyer po premierze, by widzowie mogli się nimi pobawić.

To, co mnie interesuje, to niezgodne z przeznaczeniem wykorzystywanie urządzeń, co daje zaskakujące efekty. To nas przybliża do tego, w jaki sposób technologię wykorzystywał Aaron Swartz, który programowania i hakowania używał dla dobra ludzkości. Nasz projekt ma oczywiście zupełnie inną funkcję i zasięg, niemniej sami też wykorzystujemy mechanizmy wbrew ich standardowym sposobom działania.

Odczarowujecie wizerunek hakera, który może stać się Janosikiem 2.0. Sam działasz w Akademii Młodego Hakera, która uczy najmłodszych użytkowników komputerów programowania. Dlaczego to takie ważne?

Jednym z głównych założeń Akademii Młodego Hakera jest to, że dzieciaki traktują technologię jako oczywistość, są też użytkownikami rozmaitych programów, a my chcemy im pokazać, że mogą też być twórcami programów, stron internetowych czy gier. Przekazujemy im umiejętności, które pozwalają zmieniać świat. Chodzi nam o to, by nie tylko biernie korzystały z urządzeń, co jest swoistą plagą naszych czasów, ale też by czynnie współtworzyły cyfrowy świat. Obecnie razem z Fundacją Orange przygotowujemy program dla nauczycieli, który pozwoli im prowadzić zajęcia, na których dzieci będą uczyły się programowania oraz wykorzystywania rozmaitych narzędzi do rozwijania umiejętności z zakresu danego przedmiotu, na przykład muzyki.